內容| Bruce

編輯& 排版| 環環

設計| Daisy

AI 進化史上的"USB-C時刻",2024 年11 月,Anthropic 發布的MCP 協議正在引發矽谷地震。這個被喻為"AI 界USB-C"的開放標準,不僅重構了大模型與物理世界的連接方式,更暗藏著破解AI 壟斷困局、重構數位文明生產關係的密碼。當我們還在爭論GPT-5 的參數規模時,MCP 已悄悄就通往AGI 時代的去中心化之路...

Bruce:最近在研究Model Context Protocol(MCP)。這是繼ChatGPT 之後,在AI 領域第二個讓我非常興奮的東西,因為它有希望解決我思考多年的三個問題:

- 非科學家和天才,一般人如何參與AI 產業並獲得收入?

- AI 和Ethereum 有什麼雙贏的結合之處?

- 如何實現AI d/acc?避免中心化的大公司壟斷、審查,AGI 毀滅人類?

01、MCP 是什麼?

MCP 是一個開放標準框架,可以簡化LLM 與外部資料來源和工具的整合。如果我們把LLM 比喻為Windows 作業系統,Cursor 等應用程式是鍵盤和硬件,那麼MCP 就是USB 接口,支援將外部資料和工具靈活插入,然後使用者可以讀取使用這些外部資料和工具。

MCP 提供了三種能力對LLM 進行擴展:

- Resources(知識擴展)

- Tools(執行函數,呼叫外部系統)

- Prompts(預編寫提示詞範本)

MCP 可以由任何人進行開發和託管,以Server 的方式提供,可以隨時下線停止服務。

02.為什麼需要MCP

目前LLM 使用盡可能多的資料進行大量的運算並產生大量的參數,將知識融入模型裡面,從而實現對話輸出對應知識。但是有比較大的幾個問題:

- 大量的數據和運算需要大量的時間和硬件,用於訓練的知識通常是過時的。

- 大量參數的模型,很難在本地設備部署和使用,但實際上使用者大部分場景可能並不需要全部資訊完成需求。

- 部分模型採用爬蟲的方式讀取外部資訊進行運算以實現時效性,但是由於爬蟲的限制和外部資料的質量,可能產出誤導性更強的內容。

- 由於AI 並沒有很好的為創作者帶來利益,許多網站和內容開始實施反AI 措施,產生大量垃圾訊息,將會導致LLM 的品質逐步下降。

- LLM 很難擴展到方方面面的外部功能和操作,例如準確地呼叫GitHub 介面實作一些操作,它會依照可能過時的文件產生程式碼,但無法確保可以精準執行。

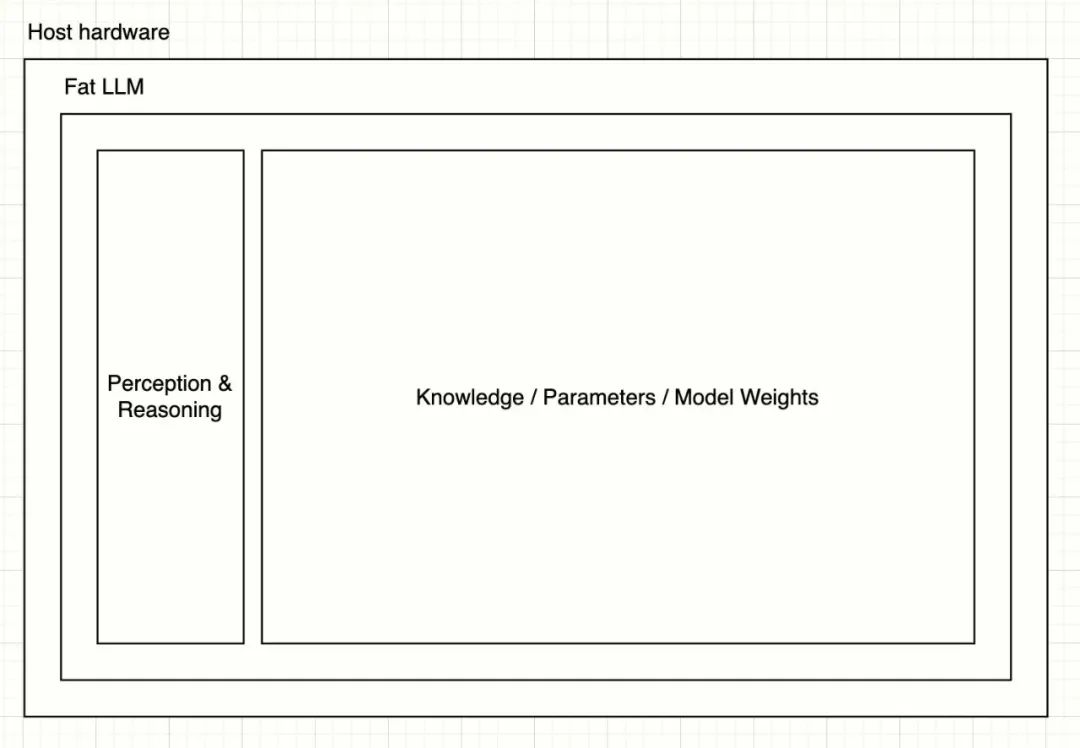

03、胖LLM 和瘦LLM + MCP 的架構演進

我們可以將目前的超大規模模型視為胖LLM,其架構可以以下面簡單圖示表示:

使用者輸入資訊之後,透過Perception & Reasoning 層對輸入進行拆解和推理,然後呼叫龐大的參數進行結果產生。

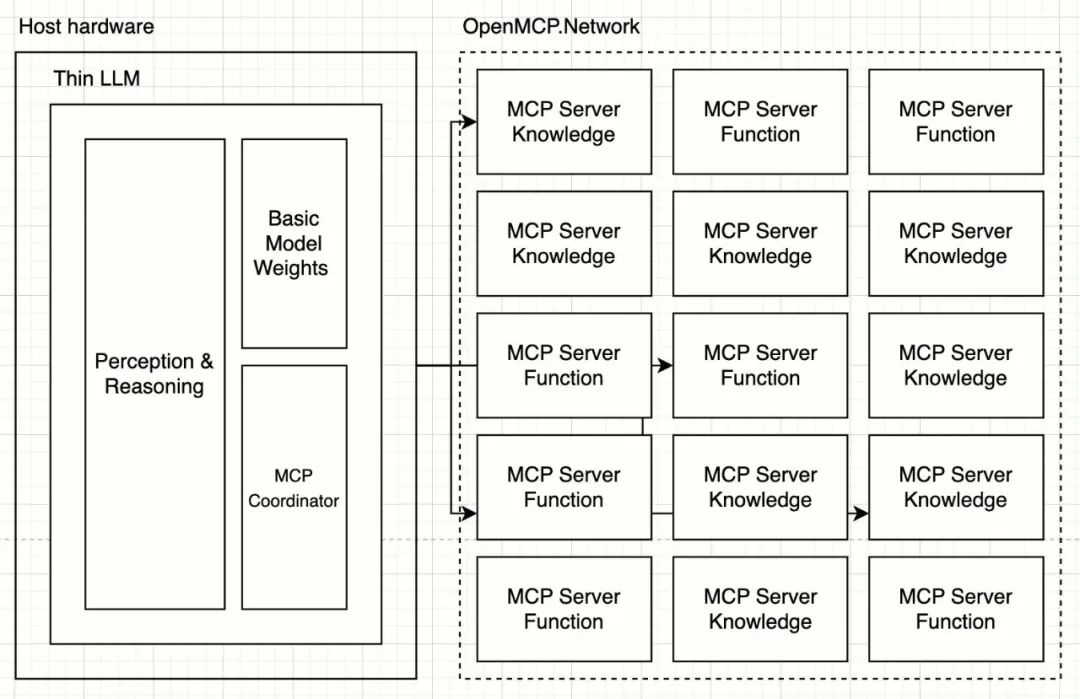

基於MCP 之後,LLM 可能聚焦在語言解析本身,剝離出知識與能力,變成瘦LLM:

在瘦LLM 的架構下,Perception & Reasoning 層將會關注如何將全方面的人類物理環境資訊解析成為tokens,包括但不限於:語音、語氣、氣味、圖像、文字、重力、氣溫等,然後透過MCP Coordinator 編排和協調多達數百的MCP Servers 完成任務。瘦LLM 的訓練成本和速度將會極速提升,對於部署設備的要求變得很低。

04、MCP 如何解決三大問題

一般人如何參與AI 產業?

任何有獨特才能的人,都可以建立自己的MCP Server 對LLM 提供服務。例如一個鳥類愛好者可以將自己多年的鳥類筆記透過MCP 對外提供服務。當有人使用LLM 搜尋跟鳥類相關的信息,就會調用到當前鳥類筆記MCP 服務。創作者也會因此獲得收入分成。

這是一種更精準和自動化的創作者經濟循環,服務內容更加標準化,調用的次數、輸出的token 都可以很精準的統計。 LLM 提供者甚至可以同時呼叫多個鳥類筆記MCP Servers 讓使用者選擇和評分來確定誰的品質更好獲得更高匹配權重。

AI 和Ethereum 的雙贏結合

a. 我們可以基於Ethereum 建構一個OpenMCP.Network 創作者激勵網絡。 MCP Server 需要託管和提供穩定的服務,使用者對LLM 供應商付費,LLM 供應商將實際的激勵透過網路分配到被呼叫的MCP Servers 上從而維持整個網路的可持續性和穩定性,激發MCP 的創作者持續創作和提供高品質內容。這套網路將需要使用智慧合約來實現激勵的自動化、透明、可信賴和抗審查。運作過程中的簽章、權限驗證、隱私保護都可以使用以太坊錢包、ZK 等技術實現。

b. 開發Ethereum 鏈上操作相關的MCP Servers,例如AA 錢包呼叫服務,使用者將支援在LLM 裡面透過語言實作錢包付款而不暴露相關私鑰和權限給LLM。

c. 還有各種開發者工具,進一步簡化Ethereum 智能合約開發和程式碼產生。

實現AI 去中心化

a. MCP Servers 將AI 的知識和能力去中心化,任何人都可以創建和託管MCP Servers,註冊到例如OpenMCP.Network 這樣的平台上面之後按照調用獲得激勵。沒有任何一家公司可以掌握全部的MCP Servers。如果一個LLM 提供者給予不公平的激勵到MCP Servers,創作者將支持屏蔽該公司,用戶得不到優質結果後將會更換其他LLM 提供者實現更公平的競爭。

b. 創作者可以對自己的MCP Servers 實現細粒度的權限控制以保護隱私和版權。瘦LLM 提供者應該透過提供合理的激勵來讓創作者貢獻高品質的MCP Server。

c. 瘦LLM 能力差距會慢慢抹平,因為人類的語言是有遍歷上限的,演進也很緩慢。 LLM 提供者將需要把目光、資金瞄向高品質的MCP Servers,而非重複使用更多顯示卡煉丹。

d. AGI 的能力將會分散和降權,LLM 僅作為語言處理和使用者交互,具體能力分佈在各個MCP Servers 裡面。 AGI 將不會威脅到人類,因為在關閉MCP Servers 之後就只能進行基礎語言對話。

05、總體回顧

- LLM + MCP Servers 的架構演進,本質上是將AI 能力的去中心化,降低了AGI 毀滅人類的風險。

- LLM 的使用方式,使其對MCP Servers 的呼叫次數和輸入輸出可以做到token 層級的統計和自動化,為AI 創作者經濟系統的搭建奠定了基礎。

- 好的經濟系統可以驅動創作者主動貢獻創作高品質MCP Servers,從而帶動整個人類的發展,實現正向飛輪。創作者不再抵禦AI,AI 也會提供更多職位和收入,將類似OpenAI 這樣的壟斷商業公司的利潤合理分配。

- 這套經濟系統,結合其特性和創作者的需求,非常適合基於Ethereum 實現。

06、未來展望:下一步的劇本演進

- MCP 或類MCP 的協定將會層出不窮,幾家大公司將開始競爭標準的定義。

- MCP Based LLM 將會出現,專注於解析和處理人類語言的小模型,附帶MCP Coordinator 接入MCP 網路。 LLM 將支援自動發現和調度MCP Servers,無需複雜手動配置。

- MCP Network 服務提供者將出現,每家有自己的經濟激勵系統,MCP 創作者將自己的Server 註冊和託管即可獲得收入。

- 如果MCP Network 的經濟激勵系統使用Ethereum 構建,基於智能合約,那麼Ethereum 網路的transactions 保守估計將增加約150 倍(按照非常保守的每天1 億次MCP Servers 的調用量,目前12s 一個Block 包括100 txs 計算)。