コンテンツ | ブルース

編集とフォーマット | Huanhuan

デザイン | デイジー

AI進化史における「USB-Cの瞬間」。2024年11月、AnthropicがリリースしたMCPプロトコルがシリコンバレーに激震を巻き起こす。 「AI世界のUSB-C」とも評されるこのオープンスタンダードは、大型モデルと物理世界の接続を再構築するだけでなく、AI独占のジレンマを打ち破り、デジタル文明の生産関係を再構築するためのコードも含んでいます。 GPT-5 のパラメータスケールについてはまだ議論が続いているが、MCP は AGI 時代の分散化への道を静かに切り開いてきた...

ブルース:現在、モデルコンテキストプロトコル (MCP) を研究しています。これは、ChatGPT に次いで AI 分野で私が興奮している 2 番目のものです。これは、私が長年考えてきた 3 つの問題を解決する可能性があるからです。

- 科学者以外の一般人や天才がAI業界に参加し、収入を得るにはどうしたらいいのでしょうか?

- AIとイーサリアムの双方にメリットのある組み合わせとは?

- AI d/acc を実装するには?中央集権的な大企業による独占と検閲を避けながら、AGI は人類を滅ぼすのでしょうか?

01. MCPとは何ですか?

MCP は、LLM と外部データ ソースおよびツールの統合を簡素化するオープン スタンダード フレームワークです。 LLM を Windows オペレーティング システム、カーソルなどのアプリケーションをキーボードとハードウェアに例えると、MCP は外部データとツールの柔軟な挿入をサポートし、ユーザーが読み取って使用できる USB インターフェイスです。

MCP は LLM を拡張する 3 つの機能を提供します。

- リソース(知識の拡張)

- ツール(関数の実行、外部システムの呼び出し)

- プロンプト(事前に作成されたプロンプトテンプレート)

MCP は誰でも開発、ホストでき、サーバーの形で提供され、いつでもオフラインにして停止できます。

02. MCP が必要な理由

現在、LLM は可能な限り多くのデータを使用して大量の計算を実行し、大量のパラメータを生成し、知識をモデルに統合して、対応する知識の対話出力を実現します。しかし、いくつか大きな問題があります。

- 大量のデータと計算には多くの時間とハードウェアが必要であり、トレーニングに使用される知識は古くなっていることがよくあります。

- 多数のパラメータを持つモデルは、ローカル デバイスに展開して使用するのが困難ですが、実際には、ほとんどのシナリオでは、ユーザーがニーズを満たすためにすべての情報を必要としない場合があります。

- 一部のモデルでは、クローラーを使用して外部情報を読み取って計算を行い、タイムリーさを実現しますが、クローラーの制限と外部データの品質により、誤解を招くコンテンツが生成される可能性が高くなります。

- AIはクリエイターに良い利益をもたらさなかったため、多くのウェブサイトやコンテンツがAI対策を導入し始め、大量のスパムが発生し、LLMの品質が徐々に低下することになります。

- LLM は、外部機能や操作のすべての側面に拡張することが困難です。たとえば、GitHub インターフェイスを正確に呼び出して、一部の操作を実装できます。古い可能性のあるドキュメントに従ってコードを生成しますが、正確な実行を保証することはできません。

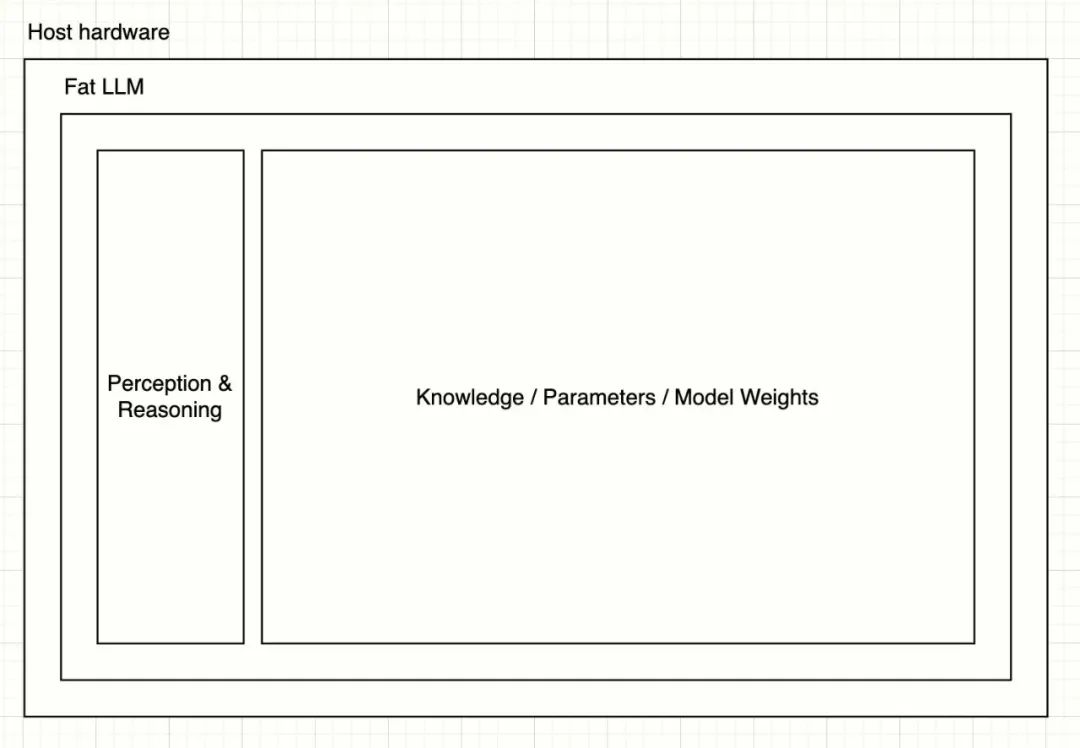

03. ファットLLMとシンLLM + MCPのアーキテクチャの進化

現在の超大規模モデルは fat LLM と見なすことができ、そのアーキテクチャは次の簡単な図で表すことができます。

ユーザーが情報を入力すると、その入力は Perception & Reasoning レイヤーを通じて分解および推論され、多数のパラメータが呼び出されて結果が生成されます。

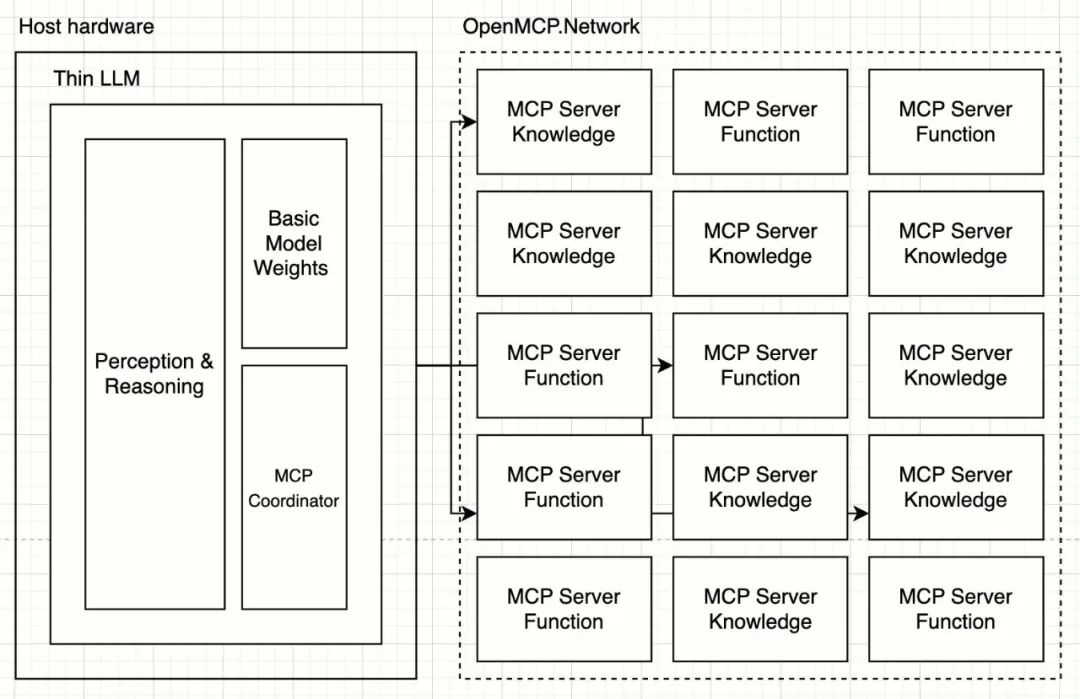

MCP に基づいて、LLM は言語解析自体に重点を置き、知識と機能を取り除いて薄い LLM になる可能性があります。

薄い LLM アーキテクチャでは、知覚および推論レイヤーは、音声、トーン、匂い、画像、テキスト、重力、温度などを含むがこれらに限定されない、人間の物理的環境情報のあらゆる側面をトークンに解析し、MCP コーディネーターを介して最大数百の MCP サーバーを編成および調整してタスクを完了する方法に重点を置きます。シン LLM のトレーニング コストと速度は急速に増加し、展開機器の要件は非常に低くなります。

04. MCP は 3 つの大きな問題をどのように解決しますか?

一般の人がAI業界に参加するにはどうすればいいのでしょうか?

独自の才能を持つ人なら誰でも、独自の MCP サーバーを作成して LLM にサービスを提供することができます。たとえば、鳥愛好家は、長年にわたって収集した鳥の記録を、MCP を通じて外部へのサービスとして提供することができます。 LLM を使用して鳥類に関する情報を検索すると、現在の鳥類ノート MCP サービスが呼び出されます。クリエイターも収益の一部を受け取ります。

これは、より正確で自動化されたクリエイター経済サイクルです。サービス内容がより標準化され、呼び出し回数と出力トークンを正確にカウントできます。 LLM プロバイダーは、複数の Bird Notes MCP サーバーを同時に呼び出して、ユーザーが選択して評価し、品質が高く、マッチングの重みが高いサーバーを決定できるようにすることもできます。

AIとイーサリアムの双方にメリットのある組み合わせ

a. Ethereum をベースにした OpenMCP.Network クリエイターインセンティブネットワークを構築できます。 MCP サーバーは安定したサービスをホストして提供する必要があります。ユーザーは LLM プロバイダーに料金を支払い、LLM プロバイダーはネットワークを通じて呼び出された MCP サーバーに実際のインセンティブを配布して、ネットワーク全体の持続可能性と安定性を維持し、MCP 作成者が高品質のコンテンツを継続的に作成して提供できるように促します。このネットワークでは、インセンティブを自動化し、透明性、信頼性、検閲耐性を高めるためにスマート コントラクトを使用する必要があります。署名、権限の検証、操作中のプライバシー保護はすべて、Ethereum ウォレットや ZK などのテクノロジーを使用して実現できます。

b. AA ウォレット呼び出しサービスなどの Ethereum チェーン操作に関連する MCP サーバーを開発します。ユーザーは、関連する秘密鍵や権限を LLM に公開することなく、LLM の言語を通じてウォレット支払いを実装できるようになります。

c. Ethereum スマート コントラクトの開発とコード生成をさらに簡素化するさまざまな開発者ツールもあります。

AIの分散化

a. MCP サーバーは AI の知識と機能を分散化します。誰でも MCP サーバーを作成してホストし、OpenMCP.Network などのプラットフォームに登録し、呼び出しに基づいてインセンティブを受け取ることができます。単一の企業がすべての MCP サーバーを制御することはできません。 LLM プロバイダーが MCP サーバーに不公平なインセンティブを与えた場合、クリエイターはその会社のブロックを支持し、質の高い結果が得られないユーザーはより公平な競争を実現するために他の LLM プロバイダーに切り替えるでしょう。

b. クリエイターは、プライバシーと著作権を保護するために、独自の MCP サーバーにきめ細かい権限制御を実装できます。シン LLM プロバイダーは、合理的なインセンティブを提供することで、作成者が高品質の MCP サーバーに貢献することを奨励する必要があります。

c. 薄い LLM 人間の言語には上限があり、非常にゆっくりと進化するため、能力のギャップは徐々に解消されます。 LLM プロバイダーは、エリクサーを作るためにグラフィック カードをさらに再利用するのではなく、高品質の MCP サーバーに注意と資金を集中させる必要があります。

d. AGI の機能は分散化され、ダウングレードされます。LLM は言語処理とユーザーインタラクションにのみ使用され、特定の機能はさまざまな MCP サーバーに分散されます。 MCP サーバーをシャットダウンした後は基本的な言語による会話のみが可能になるため、AGI は人間にとって脅威にはなりません。

05. 全体的なレビュー

- LLM + MCP サーバーのアーキテクチャの進化により、本質的に AI 機能が分散化され、AGI が人類を破壊するリスクが軽減されます。

- LLM を使用することで、MCP サーバーの呼び出し回数や入出力をトークンレベルでカウントし自動化することが可能となり、AI クリエイターの経済システム構築の基盤が築かれます。

- 優れた経済システムは、クリエイターが高品質の MCP サーバーの作成に積極的に貢献するように促し、それによって人類全体の発展を促進し、プラスのフライホイールを実現します。クリエイターはもはや AI に抵抗せず、AI はより多くの雇用と収入をもたらし、OpenAI のような独占営利企業の利益を合理的に分配するでしょう。

- この経済システムは、その特性とクリエイターのニーズと相まって、Ethereum に基づく実装に非常に適しています。

06. 今後の展望: スクリプトの進化の次のステップ

- MCP または MCP のようなプロトコルが次々と登場し、いくつかの大企業が標準の定義を競い合うようになるでしょう。

- MCP ベースの LLM が登場します。これは、人間の言語の解析と処理に重点を置いた小さなモデルで、MCP ネットワークにアクセスするために MCP コーディネーターが接続されています。 LLM は、複雑な手動構成なしで MCP サーバーの自動検出とスケジュールをサポートします。

- MCP ネットワーク サービス プロバイダーが出現し、それぞれが独自の経済的インセンティブ システムを備え、MCP 作成者は独自のサーバーを登録してホストすることで収入を得ることができます。

- MCP ネットワークの経済的インセンティブ システムが Ethereum を使用してスマート コントラクトに基づいて構築されている場合、Ethereum ネットワークのトランザクションは控えめに見積もっても約 150 倍に増加します (非常に控えめな 1 日あたりの MCP サーバーへの 1 億回の呼び出しと、100 回のトランザクションを含む現在のブロックあたり 12 秒に基づきます)。