TL/ DR

我們曾討論過AI和Web3能夠如何各取所長,在運算網路、代理平台和消費應用等各個垂直產業上相輔相成。當聚焦在資料資源這一垂直領域,Web新興代表專案為資料的獲取,共享和利用提供了新的可能性。

- 傳統數據提供商難以滿足AI和其他數據驅動產業對高品質、即時可驗證數據的需求,尤其在透明度、用戶控制和隱私保護方面存在局限性

- Web3方案正致力重塑資料生態。 MPC、零知識證明和TLS Notary 等技術確保資料在多個來源之間流通時的真實性和隱私保護,分散式儲存和邊緣運算則為資料的即時處理提供了更高的靈活性和效率。

- 其中去中心化資料網路這個新興基礎設施萌生了幾個代表性專案OpenLayer(模組化的真實資料圖層),Grass(利用使用者閒置頻寬和去中心化的爬蟲節點網路)和Vana(使用者資料主權Layer 1網路),以不同的技術路徑為AI訓練和應用等領域開闢新的前景。

- 透過眾包的容量、無信任的抽象層和基於代幣的激勵機制,去中心化資料基礎設施能夠提供比Web2超大規模服務商更私密、安全、高效且經濟的解決方案,並且賦予用戶對其數據和其相關資源的控制權,建構一個更開放、安全和互通的數位生態系統。

1. 數據需求浪潮

數據已成為各產業創新和決策的關鍵驅動。 UBS預測全球資料量預計在2020年至2030年間成長超過十倍達到660 ZB,到2025年,全球每人每天將產生463 EB(Exabytes,1EB=10億GB)的資料。數據即服務(DaaS)市場正在快速擴張,根據Grand View Research的報告,全球DaaS市場在2023年的估值為143.6億美元,預計到2030年將以28.1%的複合年增長率增長,最終達到768億美元。這些高成長的數字背後是多個產業領域對高品質、即時可信賴數據的需求。

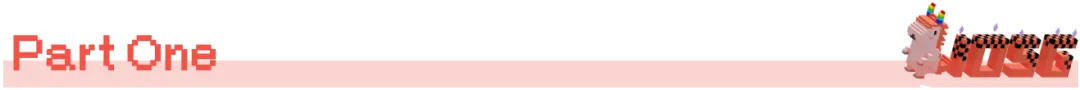

AI模型訓練依賴大量資料輸入,用於識別模式和調整參數。訓練後也需要資料集測試模型的效能和泛化能力。此外,AI agent作為未來可預見的新興智慧應用形式, 需要即時可靠的資料來源,以確保準確的決策和任務執行。

(Source: Leewayhertz)

商業分析的需求也變得多樣化和廣泛,並成為驅動企業創新的核心工具。例如社交媒體平台和市場研究公司需要可靠的用戶行為數據來製定策略和洞察趨勢, 整合多個社交平台的多元數據, 構建更全面的畫像。

對於Web3生態,鏈上也需要可靠真實數據來支援一些新型金融產品。隨著越來越多新型資產在被通證化,需要靈活且可靠的數據接口,以支援創新產品的開發和風險管理,讓智慧合約可以基於可驗證的即時數據執行。

除了以上,還有科研,物聯網(IoT)等等。新用例表面各產業對於多元、真實、即時的資料需求激增,而傳統系統可能難以應對快速成長的資料量和不斷變化的需求。

2.傳統資料生態的限制與問題

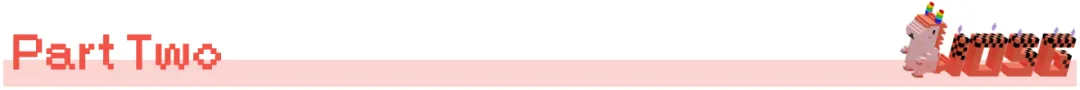

典型的資料生態系統包括資料收集、儲存、處理、分析和應用。中心化模式的特點是資料集中收集並儲存、由核心企業IT團隊管理運維, 並實施嚴格的存取控制。

例如Google的資料生態系統涵蓋了從搜尋引擎、Gmail到Android作業系統等多個資料來源,透過這些平台收集使用者資料, 儲存在其全球分佈的資料中心, 然後使用演算法處理和分析,以支撐各種產品與服務的開發與最佳化。

在金融市場舉例,數據和基礎設施LSEG(前Refinitiv)則透過從全球交易所、銀行和其他主要金融機構獲取即時和歷史數據,同時利用自有的Reuters News網絡收集市場相關新聞,運用專有演算法和模型產生分析數據和風險評估作為附加產品。

(Source: kdnuggets.com)

傳統資料架構在專業服務方面有效,但集中化模式的限制日益明顯。特別是在新興資料來源的覆蓋、透明度和用戶隱私保護方面,傳統資料生態系統正面臨挑戰。這裡例舉幾個方面:

- 資料覆蓋不足:傳統資料供應商在快速捕捉和分析如社群媒體情緒、物聯網裝置資料等新興資料來源方面存在挑戰。中心化系統難以有效率地取得和整合來自眾多小規模或非主流來源的"長尾"資料。

例如2021年GameStop事件就揭示了傳統金融資料提供者在分析社群媒體情緒時的限制。 Reddit等平台上的投資者情緒迅速改變了市場趨勢,但像Bloomberg和Reuters這樣的數據終端未能及時捕捉到這些動態,導致市場預測落後。

- 資料可訪問性受限:壟斷限制了可訪問性。許多傳統供應商透過API/雲端服務開放部分數據,但高昂的存取費用和複雜授權流程仍然增加了數據整合的難度。

鏈上開發者難以快速存取可靠的鏈下數據,高品質數據被少數巨頭壟斷,存取成本高。

- 資料透明度和可信度問題:許多中心化資料提供者對其資料收集和處理方法缺乏透明度,且缺乏有效的機制來驗證大規模資料的真實性和完整性。大規模即時數據的驗證仍然是一個複雜的問題, 中心化的本質也增加了數據被篡改或操縱的風險。

- 隱私權保護與資料所有權:大型科技公司大規模商用了使用者資料。使用者作為私人資料的創造者,很難從中獲得應有的價值回報。使用者通常無法了解他們的資料如何被收集、處理和使用,也難以決定資料的使用範圍和方式。過度收集和使用也導致嚴重的隱私風險。

例如,Facebook的Cambridge Analytica事件就揭露了傳統資料提供者如何在資料使用透明度和隱私權保護方面存在巨大漏洞。

- 資料孤島:此外,不同來源、格式的即時資料難以快速整合,影響了全面分析的可能性。許多數據往往被鎖在組織內部,限制了跨產業和跨組織的數據共享和創新,數據孤島效應阻礙了跨域的數據整合和分析。

例如在消費產業,品牌需要整合電商平台、實體店、社群媒體和市場研究的數據,但這些數據可能因為平台形式不統一或被隔離,難以整合。再例如,像Uber和Lyft這樣的共享出行公司,雖然它們都收集大量來自用戶的,關於交通、乘客需求和地理位置的即時數據,但由於競爭關係,這些數據無法提出並共享整合。

除此之外,還有成本效率、彈性等問題。傳統數據商正在積極應對這些挑戰, 但異軍突起的Web3技術為解決這些問題提供了新的思路和可能性。

3.Web3資料生態

自2014年IPFS(InterPlanetary File System)等去中心化儲存方案發布以來,業界湧現一系列新興項目,致力於解決傳統資料生態的限制。我們看到去中心化資料解決方案已經形成了一個多層次、相互連接的生態系統,涵蓋了資料生命週期的各個階段,包括資料生成、儲存、交換、處理與分析、驗證與安全,以及隱私與所有權。

- 資料儲存: Filecoin和Arweave的快速發展證明了去中心化儲存(DCS)正在成為儲存領域的範式轉移。 DCS方案透過分散式架構減少了單點故障風險,同時以更具競爭力的成本效益吸引參與者。隨著一系列規模化應用案例的湧現,DCS的儲存容量呈現爆發式成長(例如Filecoin網路的總儲存容量在2024年已達到22 exabytes)。

- 處理與分析: Fluence等去中心化資料運算平台透過邊緣運算(Edge Computing)技術提高了資料處理的即時性和效率,特別適用於物聯網(IoT)和AI推理等對即時性要求較高的應用場景。 Web3專案利用聯邦學習、差分隱私、可信任執行環境、全同態加密等技術在運算層上提供靈活的隱私保護和權衡。

- 資料市場/交換平台:為了促進資料的價值量化和流通,Ocean Protocol透過代幣化和DEX機制, 創建了高效且開放的資料交換管道, 例如幫助傳統製造公司(賓士母公司Daimler)合作開發資料交換市場,以幫助其供應鏈管理中的數據分享。另一方面,Streamr則創造了適用於IoT和即時分析場景的無許可、訂閱式資料流網絡,在交通、物流專案中顯示了出色的潛力(例如與芬蘭智慧城市專案合作)。

隨著資料交換和利用的日益頻繁,資料的真實性、可信度和隱私保護成為了不可忽視的關鍵問題。這促使Web3生態系統將創新延伸到了資料驗證和隱私保護領域,催生了一系列突破性的解決方案。

3.1 資料驗證與隱私權保護的革新

許多web3技術及原生專案正致力於解決資料真實性和私有資料保護問題。除了ZK,MPC等技術發展被廣泛應用,其中傳輸層安全協定公證(TLS Notary)作為一種新興的驗證方法尤其值得關注。

TLS Notary簡介

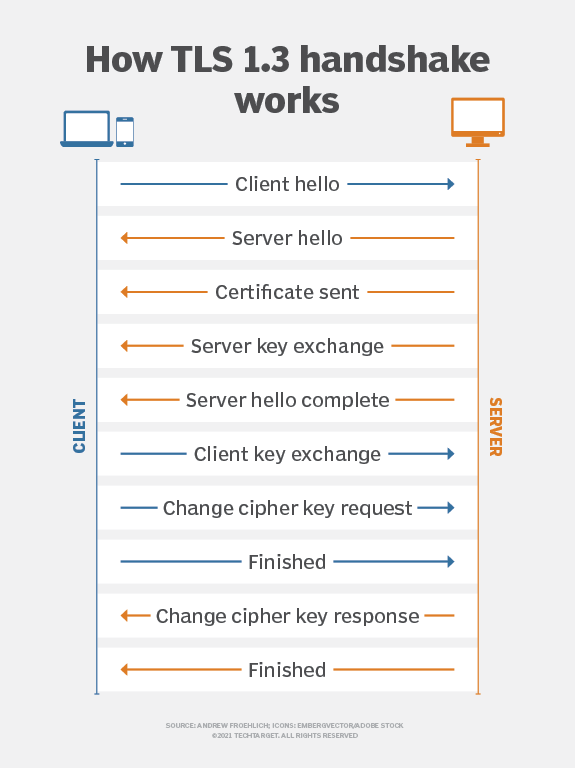

傳輸層安全協議(TLS)是一種廣泛用於網路通訊的加密協議,旨在確保客戶端和伺服器之間的資料傳輸的安全性、完整性和保密性。它是現代網路通訊中常見的加密標準,被用於HTTPS、電子郵件、即時通訊等多個場景。

十年前誕生之際,TLS Notary的最初目標是透過在客戶端(Prover)、伺服器以外引入第三方「公證人」來驗證TLS會話的真實性。

使用金鑰分割技術,TLS會話的主金鑰被分為兩部分,分別由客戶端和公證人持有。這種設計允許公證人作為可信任第三方參與驗證過程,但不能存取實際通訊內容。這種公證機制旨在偵測中間人攻擊、防止詐欺性證書,確保通訊資料在傳輸過程中沒有被竄改,並允許受信任的第三方確認通訊的合法性,同時保護通訊隱私。

由此,TLS Notary提供了安全的資料驗證,並有效平衡了驗證需求和隱私保護。

在2022年, TLS Notary專案由以太坊基金會的隱私和擴展探索(PSE)研究實驗室重新建構。新版的TLS Notary協定從頭開始用Rust語言重寫, 融入了更多先進的加密協定(如MPC), 新的協定功能允許用戶向第三方證明他們從伺服器接收到的資料的真實性,同時不洩漏資料內容。在維持原有TLS Notary核心驗證功能的同時,大幅提升了隱私保護能力,使其更適合當前和未來的資料隱私需求。

3.2 TLS Notary的變體與擴展

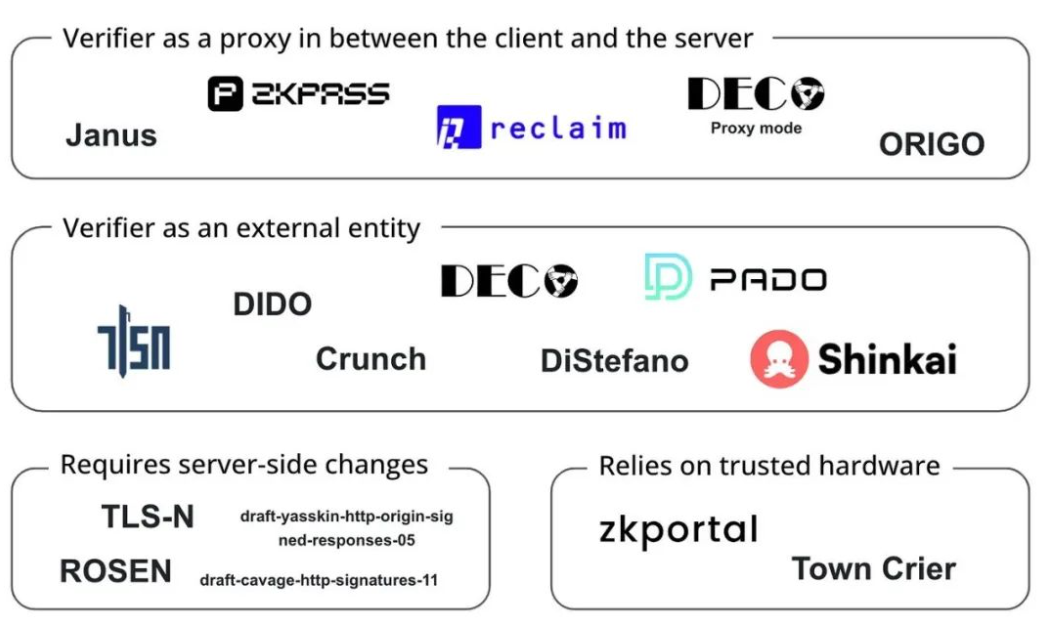

近年來TLS Notary技術也持續演進,在基礎上發展產生了多個變體,進一步增強了隱私和驗證功能:

- zkTLS: TLS Notary的隱私增強版本,結合了ZKP技術,允許使用者產生網頁資料的加密證明,而無需暴露任何敏感資訊。它適用於需要極高隱私保護的通訊場景。

- 3P-TLS (Three-Party TLS):引進了客戶端、伺服器和稽核者三方,在不洩漏通訊內容的情況下,允許稽核者驗證通訊的安全性。這項協議在需要透明度但同時要求隱私保護的場景中非常有用,例如合規審查或金融交易的審計。

Web3專案們使用這些加密技術來增強資料驗證和隱私保護,打破資料壟斷,解決資料孤島和可信賴傳輸問題,讓使用者得以不洩露隱私地證明如社媒帳號擁有權、用以金融借貸的購物記錄,銀行信用記錄、職業背景和學歷認證等信息,例如:

- Reclaim Protocol 使用zkTLS技術,產生HTTPS流量的零知識證明,允許使用者從外部網站安全地匯入活動、聲譽和身分數據,而無需暴露敏感資訊。

- zkPass 結合3P-TLS技術,讓使用者無洩漏地驗證真實世界的私有數據,廣泛應用於KYC、信用服務等場景,並且與HTTPS網路相容。

- Opacity Network 基於zkTLS,讓用戶安全地證明他們在各個平台(如Uber、Spotify、Netflix等)的活動,而無需直接存取這些平台的API。實現跨平台活動證明。

(Projects working on TLS Oracles, Source: Bastian Wetzel)

Web3資料驗證作為資料生態鏈上的重要環節,應用前景十分廣闊,其生態的興榮正引導著一個更開放、動態和以使用者為中心的數位經濟。然而,真實性驗證技術的發展只是建構新一代資料基礎設施的開始。

4. 去中心化資料網絡

有些專案則結合上述的資料驗證技術,在資料生態的上游,即資料溯源、資料的分散式擷取和可信任傳輸上做出更深入的探索。以下將重點放在幾個代表性項目:OpenLayer,Grass和Vana,它們在建立新一代資料基礎設施方面展現出獨特的潛力。

4.1 OpenLayer

OpenLayer是a16z Crypto 2024春季加密創業加速器專案之一,作為首個模組化的真實資料層,致力於提供一個創新的模組化解決方案,用於協調資料的收集、驗證和轉換,同時滿足Web2和Web3公司的需求。 OpenLayer已吸引了包括Geometry Ventures、LongHash Ventures在內的知名基金和天使投資者的支持。

傳統資料層有多重挑戰:缺乏可信賴驗證機制,依賴中心化架構導致存取性受限,不同系統間的資料缺乏互通性和流動性,同時也沒有公平的資料價值分配機制。

一個更具象化的問題是,當今AI訓練資料正變得日益稀缺。在公共網路上,許多網站開始透過反爬蟲限制措施來防止AI公司大規模抓取資料。

而在私密專有資料方面,情況則更為複雜,許多有價值的資料由於其敏感性質而以隱私保護的方式存儲,缺乏有效的激勵機制。在這種現狀下,使用者無法安全地透過提供私人資料來獲得直接收益,因此不願意分享這些敏感資料。

為了解決這些問題,OpenLayer結合資料驗證技術建構了一個模組化真實資料層(Modular Authentic Data Layer),並以去中心化+經濟激勵的方式來協調資料收集、驗證和轉換過程,為Web2和Web3公司提供一個更安全、高效、靈活的資料基礎設施。

4.1.1OpenLayer模組化設計的核心組件

OpenLayer提供了一個模組化的平台以簡化資料的收集、可信任驗證和轉換流程:

a) OpenNodes

OpenNodes是OpenLayer生態系統中負責去中心化數據收集的核心組件,透過用戶的行動應用、瀏覽器擴展等渠道收集數據,不同的運營商/節點可以根據其硬體規格執行最適合的任務而優化回報。

OpenNodes支援三種主要的資料類型,以滿足不同類型任務的需求:

- 公開可用的網路數據(如金融數據、天氣數據、體育數據和社交媒體串流)

- 用戶私人資料(如Netflix觀看歷史、Amazon訂單記錄等)

- 來自安全來源的自報告資料(如由專有所有者簽署或特定可信任硬體驗證的資料)。

開發者可以輕鬆新增新的資料類型,指定新的資料來源,需求和資料檢索方法, 使用者可以選擇提供去識別化的資料以換取獎勵。這種設計使得系統可以不斷擴展以適應新的資料需求,多樣化的資料來源使得OpenLayer能夠為各種應用場景提供全面的資料支持,也降低了資料提供的門檻。

b) OpenValidators

OpenValidators負責收集之後的資料驗證,讓資料消費者確認使用者提供的資料與資料來源的完全匹配。所有提供的驗證方法可以進行加密證明的, 驗證結果可以在事後被證實。同一類型的證明,有多個不同的提供者提供服務。開發者可以根據自己的需求選擇最適合的驗證提供者。

在初始用例中,特別是針對來自互聯網API的公共或私有資料, OpenLayer以TLSNotary作為驗證解決方案,從任何Web應用程式導出資料,並在不損害隱私的情況下證明資料的真實性。

不限於TLSNotary,得益於其模組化設計, 驗證系統可以輕鬆接入其他驗證方法,以適應不同類型的數據和驗證需求包括但不限於:

- Attested TLS connections: 利用可信任執行環境(TEE)建立經過認證的TLS連線,確保資料在傳輸過程中的完整性和真實性。

- Secure Enclaves: 使用硬體層級的安全隔離環境(如Intel SGX)來處理和驗證敏感資料,提供更高層級的資料保護。

- ZK Proof Generators: 整合ZKP, 允許在不洩露原始資料的情況下驗證資料的屬性或計算結果。

c) OpenConnect

OpenConnect是OpenLayer生態系統中負責資料轉換,實現可用性的核心模組,處理來自各種來源的資料, 確保資料在不同系統間的互通性,以滿足不同應用的需求。例如:

- 將資料轉換為鏈上預言機(Oracle)格式,便於智能合約直接使用。

- 將非結構化原始資料轉換為結構化資料,為AI訓練等目的進行預處理。

對於來自用戶私人帳戶的資料,OpenConnect提供了資料脫敏功能以保護隱私,也提供了組件來增強資料共享過程中的安全性,減少資料外洩和濫用。為了滿足AI和區塊鏈等應用對即時數據的需求, OpenConnect支援高效的即時數據轉換。

當下,透過和Eigenlayer的集成,OpenLayer AVS運營商監聽數據請求任務,負責抓取數據並進行驗證,然後將結果報告回系統,通過EigenLayer質押或重質押資產,為其行為提供經濟擔保。如惡意行為被證實,將面臨質押資產被罰沒的風險。作為EigenLayer主網上最早的的AVS(主動驗證服務)之一,OpenLayer已經吸引了超過50個運營商和40億美元的再質押資產。

總的來說,OpenLayer所建構的去中心化資料層在不犧牲實用性和效率的前提下,擴展了可用資料的範圍和多樣性, 同時透過加密技術和經濟激勵,確保了資料的真實性和完整性。其技術對於尋求獲取鏈下資訊的Web3 Dapp、需要用真實輸入來訓練和推斷的AI模型,以及希望根據現有身分和聲譽來細分和定位用戶的公司都有廣泛的實際用例。用戶也得以價值化他們的私有資料。

4.2 Grass

Grass是由Wynd Network開發的旗艦項目,旨在創建一個去中心化的網路爬蟲和AI訓練資料平台。在2023年末,Grass計畫完成了由Polychain Capital和Tribe Capital領投的350萬美元種子輪融資。緊接著,在2024年9月,計畫迎來了由HackVC領投的A輪融資,Polychain、Delphi、Lattice和Brevan Howard等知名投資機構也參與其中。

我們提到AI訓練需要新的資料敞口,而其中一個解決方案是使用多IP 來突破資料存取的權限,為AI進行資料餵食。 Grass由此出發,創造了一個分散式爬蟲節點網絡, 專門致力於以去中心化實體基礎設施的方式,利用使用者的閒置頻寬為AI訓練收集並提供可驗證資料集。節點透過使用者的網際網路連線路由web請求, 造訪公開網站並編譯結構化資料集。它使用邊緣運算技術進行初步資料清理和格式化,提高資料品質。

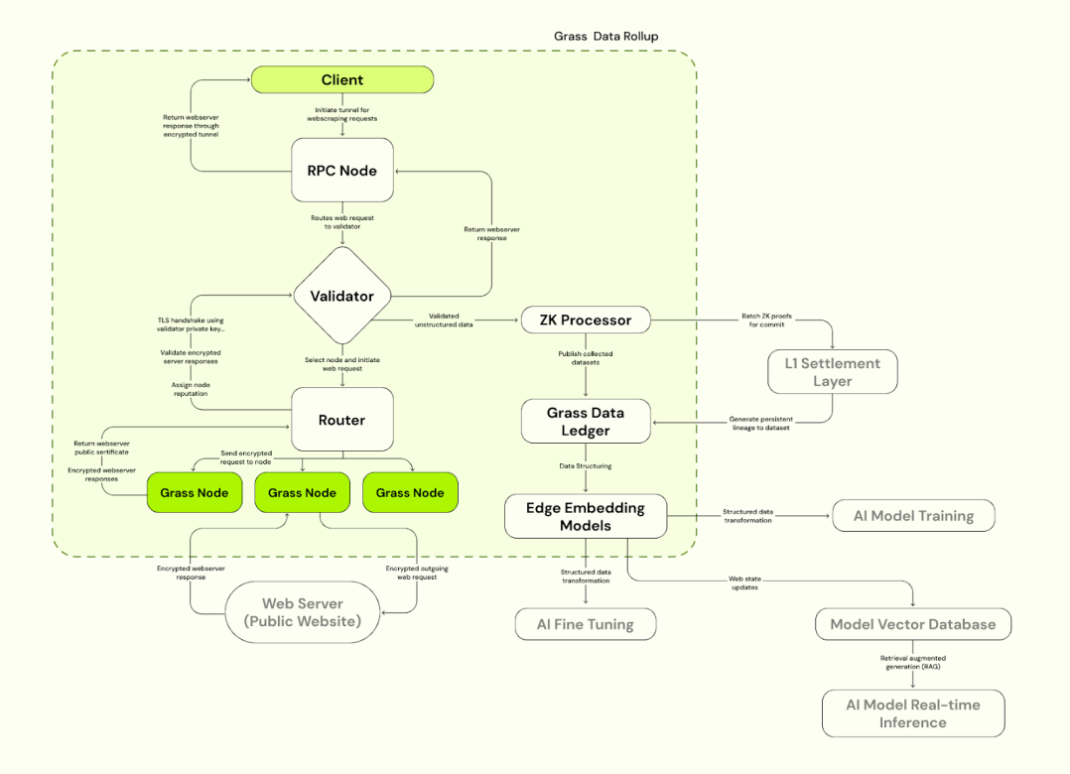

Grass採用了Solana Layer 2 Data Rollup架構,建立在Solana之上以提高處理效率。 Grass使用驗證器接收、驗證和批次來自節點的web交易,產生ZK證明以確保資料真實性。驗證後的資料儲存在資料帳本(L2)中,並連結到對應的L1鏈上證明。

4.2.1 Grass主要組件

a)Grass節點

與OpenNodes類似,C端用戶安裝Grass應用或瀏覽器擴展並運行, 利用閒置頻寬進行網絡爬蟲操作, 節點通過用戶的互聯網連接路由web請求, 訪問公開網站並編譯結構化數據集,使用邊緣計算技術進行初步資料清理和格式化。用戶根據貢獻的頻寬和資料量獲得GRASS代幣獎勵。

b) 路由器(Routers)

連接Grass節點和驗證器,管理節點網路並中繼頻寬。 Routers被激勵運營並獲得獎勵,獎勵比例與通過其中繼的總驗證頻寬成正比。

c) 驗證器(Validators)

接收、驗證和批次來自路由器的web交易, 產生ZK證明,使用獨特的金鑰集來建立TLS連線,為與目標web伺服器的通訊選擇適當的密碼套件。 Grass目前採用中心化驗證者,未來計畫轉向驗證者委員會。

d) ZK處理器(ZK Processor)

接收來自驗證者的產生每個節點會話資料的證明,批次所有web請求的有效性證明並提交到Layer 1(Solana)。

e) Grass資料帳本(Grass L2)

儲存完整的資料集,並連結到相應的L1鏈(Solana)上證明。

f) 邊緣嵌入模型

負責將非結構化web資料轉換為可用與AI訓練的結構化模型。

Source:Grass

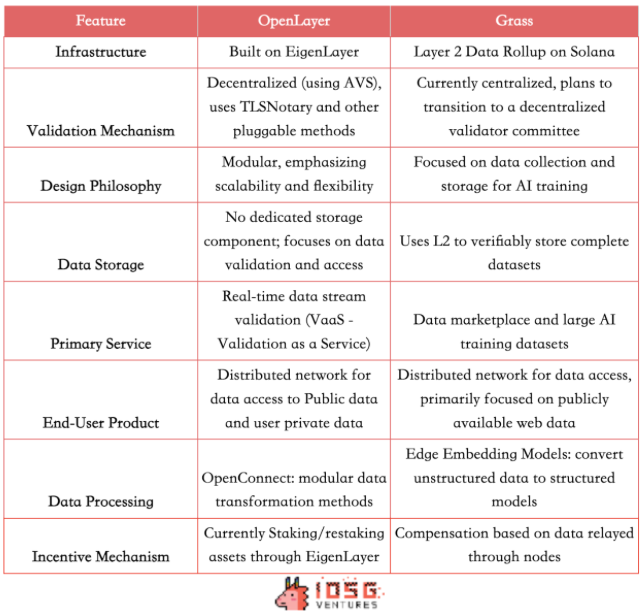

分析對比Grass和OpenLayer

OpenLayer和Grass都利用分散式網路為公司提供了存取開放網路資料和需要身份驗證的封閉資訊的機會。以激勵機制促進了數據共享和高品質數據的生產。兩者都致力於創造一個去中心化資料層(Decentralized Data Layer)以解決資料擷取存取和驗證的問題, 但採用了略有不同的技術路徑和商業模式。

技術架構的不同

Grass使用Solana上的Layer 2 Data Rollup架構, 目前採用中心化的驗證機制, 使用單一的驗證器。而Openlayer作為首批AVS,基於EigenLayer建構, 利用經濟誘因和罰沒機制實現去中心化的驗證機制。並採用模組化設計,強調資料驗證服務的可擴充性和靈活性。

產品差異

兩者都提供了類似的To C產品,允許用戶透過節點進行資料的價值變現。在To B用例上,Grass提供了一個有趣的數據市場模型,並使用L2來可驗證地儲存完整的數據,來為AI公司提供結構化、高品質、可驗證的訓練集。而OpenLayer並沒有暫時專用的數據存儲組件,但提供更廣泛的即時數據流驗證服務(Vaas),除了為AI提供數據,也適用於需要快速響應的場景,例如作為Oracle為RWA/DeFi/預測市場項目餵價,提供即時社交數據等等。

因此,如今Grass的目標客戶群主要針對AI公司和資料科學家,提供大規模、結構化的訓練資料集,也服務於需要大量網路資料集的研究機構和企業;而Openlayer則暫時面向需要鏈下資料源的鏈上開發者,需要即時、可驗證的資料流的AI公司,以及支援創新的用戶獲取策略,如驗證競品使用歷史的Web2公司。

未來的潛在競爭

然而,考慮到產業發展趨勢, 兩個項目的功能確實有可能在未來趨同。 Grass不久後也可能提供即時的結構化資料。而OpenLayer作為一個模組化平台,未來也有可能擴展到資料集管理擁有自己的data ledger, 因此兩者的競爭領域可能會逐漸重疊。

並且,兩個項目都可能會考慮加入資料標註(data labelling)這一關鍵環節。 Grass在這方面可能會更快推進, 因為他們擁有龐大的節點網絡- 據報道已超過220萬個活躍節點。這項優勢使Grass有潛力提供基於人類回饋的強化學習(RLHF)服務,利用大量標註資料來優化AI模型。

然而,OpenLayer憑藉其在數據驗證和實時處理方面的專長, 其在私人數據的專注,可能會在數據質量和可信度方面保持優勢。此外,OpenLayer作為Eigenlayer的AVS之一, 可能在去中心化驗證機制上有更深入的發展。

儘管兩個項目可能在某些領域競爭, 但它們各自的獨特優勢和技術路線也可能導致它們在數據生態系統中佔據不同的利基市場。

4.3 VAVA

作為一個以使用者為中心的資料池網絡,Vana同樣致力於為AI和相關應用提供高品質資料。相較於OpenLayer和Grass,Vana採用了更不同的技術路徑和商業模式。 Vana在2024年9月完成500萬美元融資,由Coinbase Ventures領投,先前獲得Paradigm領投的1800萬美元A輪融資,其他知名投資者包括Polychain, Casey Caruso等。

最初於2018年作為MIT的研究計畫啟動,Vana旨在成為一個專為用戶私有資料設計的Layer 1區塊鏈。其在資料所有權和價值分配上做出的創新使用戶能夠從基於其資料訓練的AI模型中獲利。 Vana的核心在於透過無需信任、私密且可歸因的資料流動性池(Data Liquidity Pool)和創新的Proof of Contribution 機制來實現私人資料的流通和價值化:

4.3.1. 資料流動性池(Data Liquidity Pool)

Vana 引入了一個獨特的資料流動性池(DLP)概念:作為Vana網路的核心元件,每個DLP都是一個獨立的點對點網絡,用於聚合特定類型的資料資產。用戶可以將他們的私人資料(如購物記錄、瀏覽習慣、社交媒體活動等)上傳至特定DLP,並靈活選擇是否將這些資料授權給特定的第三方使用。資料透過這些流動性池被整合和管理,這些資料經過去識別化處理,確保使用者隱私的同時允許資料參與商業應用,例如用於AI 模型訓練或市場研究。

用戶向DLP提交資料並獲得相應的DLP代幣(每個DLP都有特定的代幣)獎勵,這些代幣不僅代表用戶對資料池的貢獻,還賦予用戶對DLP的治理權和未來利潤分配權。用戶不僅可以分享數據,還可以從數據的後續調用中獲取持續的收益(並提供視覺化追蹤)。與傳統的單次數據售賣不同,Vana 允許數據持續參與經濟循環。

4.3.2. Proof of Contribution 機制

Vana 的另一個核心創新之一是Proof of Contribution(貢獻證明)機制。這是Vana確保資料品質的關鍵機制,讓每個DLP可以根據其特性自訂獨特的貢獻證明函數,以驗證資料的真實性和完整性,並評估資料對AI模型效能提升的貢獻。此機制確保用戶的數據貢獻被量化和記錄,從而為用戶提供獎勵。與加密貨幣中的「工作量證明」(Proof of Work)類似,Proof of Contribution 根據用戶貢獻的資料品質、數量以及被使用的頻率來為用戶分配收益。透過智慧合約自動執行,確保貢獻者獲得與其貢獻相符的獎勵。

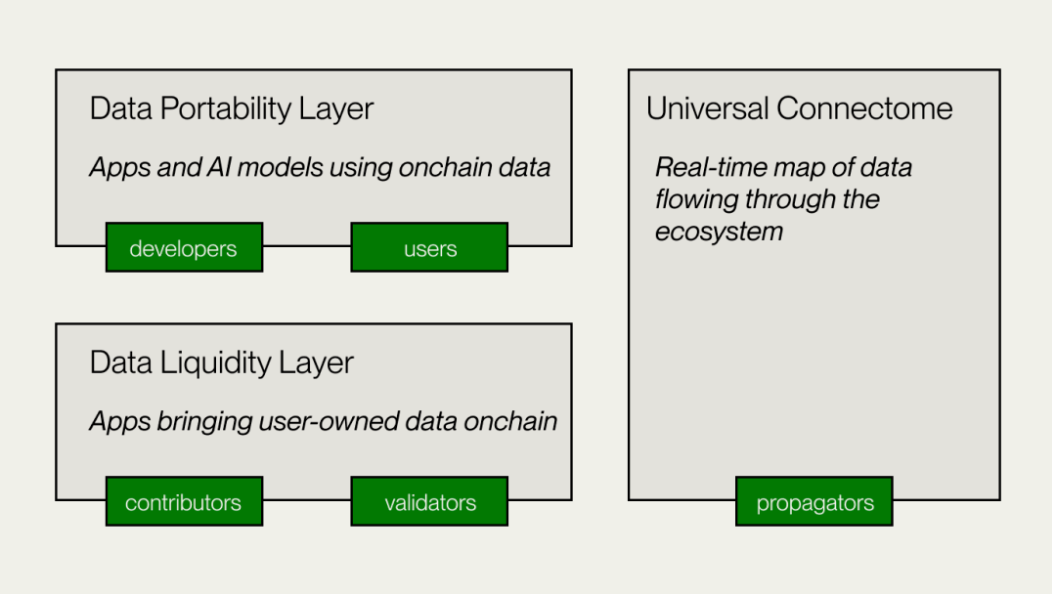

Vana的技術架構

1.資料流動性層(Data Liquidity Layer)

這是Vana的核心層,負責數據的貢獻、驗證和記錄到DLPs,將數據作為可轉移的數位資產引入鏈上。 DLP創建者部署DLP智能合約,設定資料貢獻目的、驗證方法和貢獻參數。資料貢獻者和託管者提交資料進行驗證,貢獻證明(PoC)模組會執行資料驗證和價值評估,根據參數給予治理權和獎勵。

2.資料可移植層(Data Portability Layer)

這是資料貢獻者和開發者的開放資料平台,也是Vana的應用層。 Data Portability Layer為資料貢獻者和開發者提供一個協作空間,以使用DLPs中累積的資料流動性建構應用。為User-Owned模型分散式訓練,AI Dapp開發提供基礎設施。

3.通用連接組(Connectome)

一個去中心化帳本,也是一個貫穿整個Vana生態系統的即時資料流程圖,使用權益證明共識(Proof of Stake)記錄Vana生態系統中的即時資料交易。確保DLP代幣的有效轉移並為應用提供跨DLP資料存取。與EVM相容,允許與其他網路、協定和DeFi應用程式互通。

Vana 提供了一條較為不同的路徑,專注於使用者資料的流動性和價值賦能,這種去中心化的資料交換模式不僅適用於AI 訓練、資料市場等場景,也為Web3 生態系統中使用者資料的跨平台互通與授權提供了一個新的解決方案,最終創建一個開放的互聯網生態系統,讓用戶擁有並管理自己的數據,以及由這些數據創造的智慧產品。

5.去中心化資料網路的價值主張

資料科學家克萊夫·哈姆比(Clive Humby)在2006年說過數據是新時代的石油。近20年間,我們見證了"提煉"技術的快速發展。大數據分析、機器學習等技術使得資料價值得到了空前釋放。根據IDC的預測,到2025年,全球資料圈將成長到163 ZB,其中大部分將來自個人用戶,隨著IoT、穿戴式裝置、AI 與個人化服務等新興科技的普及,未來大量需要商用的數據將也將來源自於個人。

傳統方案的痛點:Web3 的解鎖創新

Web3資料解決方案透過分散式節點網絡,突破了傳統設施的局限,實現了更廣泛、更有效率的資料擷取,同時提升了特定資料的即時取得效率和驗證可信度。在此過程中,Web3 技術確保了資料的真實性和完整性,並能有效保護使用者隱私,從而實現更公平的資料利用模式。這種去中心化的資料架構,推動了資料獲取的民主化。

不管是OpenLayer和Grass的用戶節點模式,還是Vana 透過用戶私有數據的貨幣化,除了提高特定數據收集的效率,也讓普通用戶共享數據經濟的紅利,創造一種用戶與開發者雙贏的模式,讓用戶真正掌控並獲益於他們的數據和相關資源。

透過代幣經濟,Web3 數據方案重新設計了激勵模型,創造了一個更公平的數據價值分配機制。吸引了大量用戶、硬體資源與資本的注入,從而協調並優化了整個數據網路的運作。

比起傳統資料解決方案,它們也擁有模組化與可擴充性:例如Openlayer的模組化設計,為未來的技術迭代和生態擴展提供了靈活性。得益於技術特性,優化AI模型訓練的資料取得方式,提供更豐富、更多樣化的資料集。

從資料產生、儲存、驗證到交換與分析,Web3驅動的解決方案透過獨特技術優勢解決者傳統設施的許多弊端,同時也賦予使用者對個人資料的變現能力,引發資料經濟模式的根本轉變。隨著技術進一步發展演進和應用場景的擴大,去中心化資料層有望和其他Web3資料解決方案一起,成為下一代關鍵基礎設施,為廣泛的數據驅動型產業提供支援。