作者: Eugene Cheah

編譯:J1N,Techub News

AI 算力成本下降,將激發新創公司利用低成本資源進行創新的熱潮。

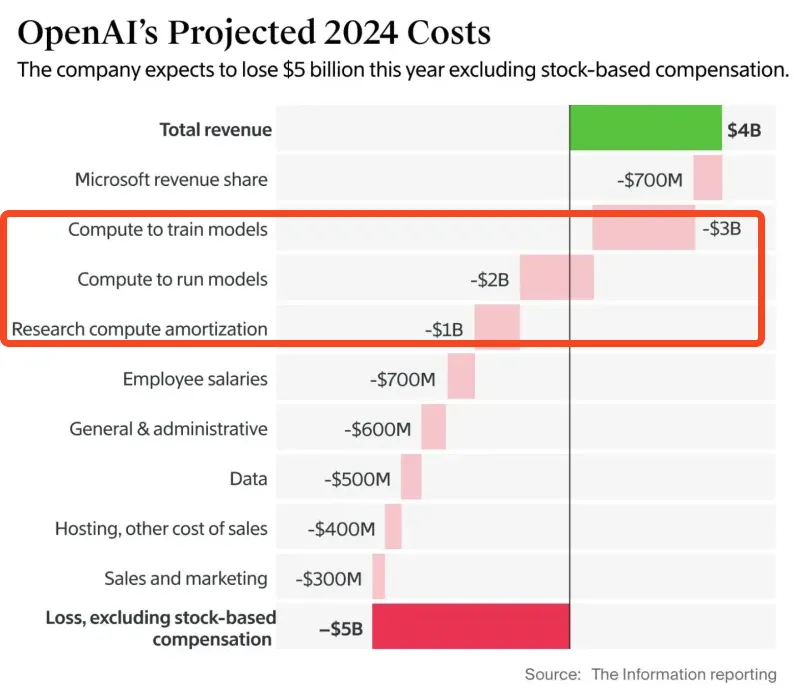

去年由於AI 算力供應緊張,H100 的租賃價格高達每小時8 美元,但現在市場上算力供應過剩,價格降到了每小時2 美元以下。這是由於一些公司在早期簽署了算力租賃合同,為了不讓過剩的算力浪費,於是開始轉售其預留的計算資源,而市場大多選擇使用開源模型,導致新模型的需求減少。現在,市場上H100 的供應量遠超需求,因此租用H100 比購買更划算,投資購買新的H100 已不再具有收益。

AI 競賽簡史

GPU 算力市場的價格一路飆升,H100 最初的租金約為每小時4.70 美元,漲到最高超過8 美元。這是由於專案創辦人為了實現下一輪融資,並說服投資者,必須抓緊時間訓練他們的AI 模型。

ChatGPT 於2022 年11 月推出,使用的是A100 系列的GPU。到了2023 年3 月,NVIDIA 推出了新的H100 系列GPU,在宣傳中提到H100 的效能比A100 強3 倍,但價格卻只比A100 高2 倍。

這對AI 新創公司來說是一個巨大的吸引力。因為GPU 的性能直接決定了他們可以開發的AI 模型的速度和規模。 H100 的強大性能意味著這些公司能夠開發出比以前更快、更大、更有效率的AI 模型,甚至有可能追趕或超過像OpenAI 這樣的行業領導者。當然,這一切的前提是他們擁有足夠的資本來購買或租用大量的H100。

由於H100 的表現大大提升,再加上AI 領域的激烈競爭,許多新創公司都投入了巨額資金來搶購H100,用它來加速他們的模型訓練。這種需求的激增導致H100 的租賃價格暴漲,最初每小時4.70 美元,但後來漲到超過8 美元。

這些新創公司之所以願意支付高昂的租金,是因為他們急於快速訓練模型,以便在下一輪融資中吸引投資者的注意,爭取到數億美元的資金來繼續擴展他們的業務。

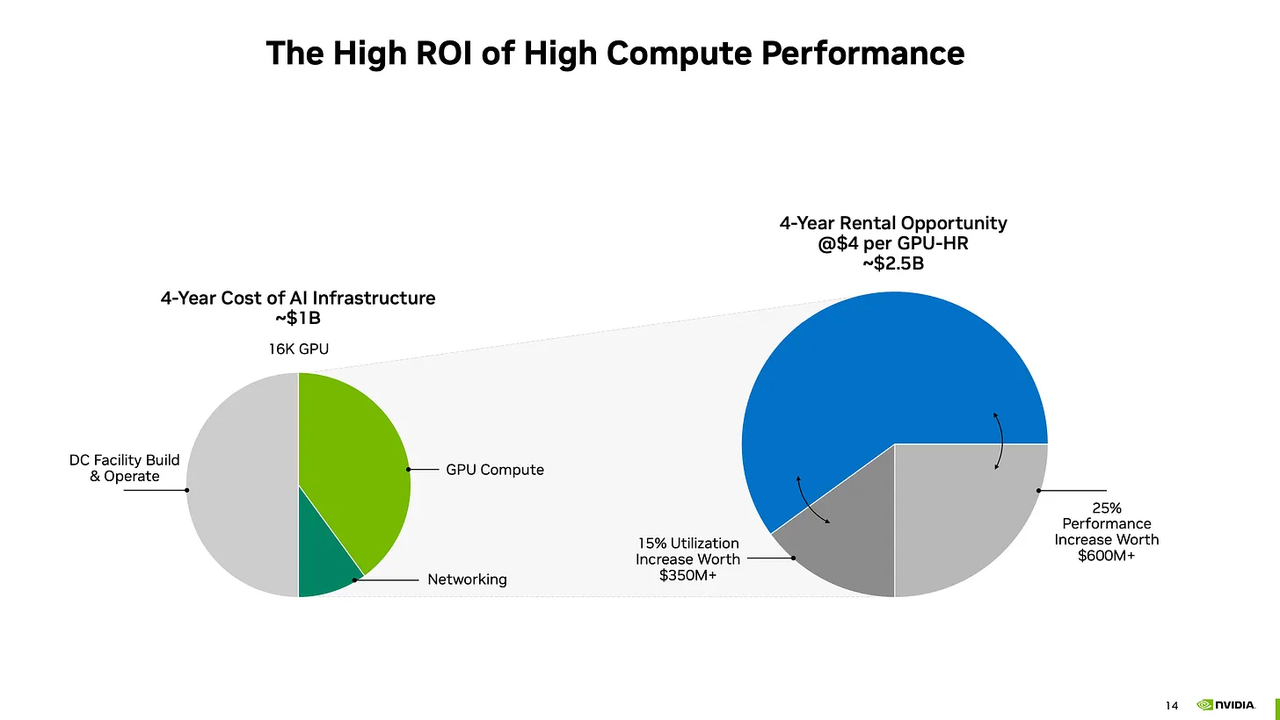

對於擁有大量H100 GPU 的算力中心(農場)來說,租賃GPU 的需求非常高,這就像是「送上門來的錢」。原因是這些AI 新創公司急於租用H100 來訓練他們的模型,甚至願意預付租金。這意味著GPU 農場可以以長期的每小時4.70 美元(或更高)租出他們的GPU。

根據計算,如果他們能以這種價格持續出租GPU,那麼他們投資購買H100 的回報週期(即收回購買成本的時間)將不到1.5 年。回報期結束後,之後每台GPU 每年能帶來超過10 萬美元的淨現金流收入。

由於對H100 和其他高性能GPU 的需求持續高漲,GPU 農場的投資者看到了巨大的利潤空間,因此他們不僅同意了這種商業模式,甚至還追加了更大的投資,購買更多GPU 以賺取更多利潤。

《鬱金香的愚蠢》 :創作於有記載的歷史上第一次投機泡沫之後,鬱金香價格在1634 年持續攀升,並於1637 年2 月崩盤

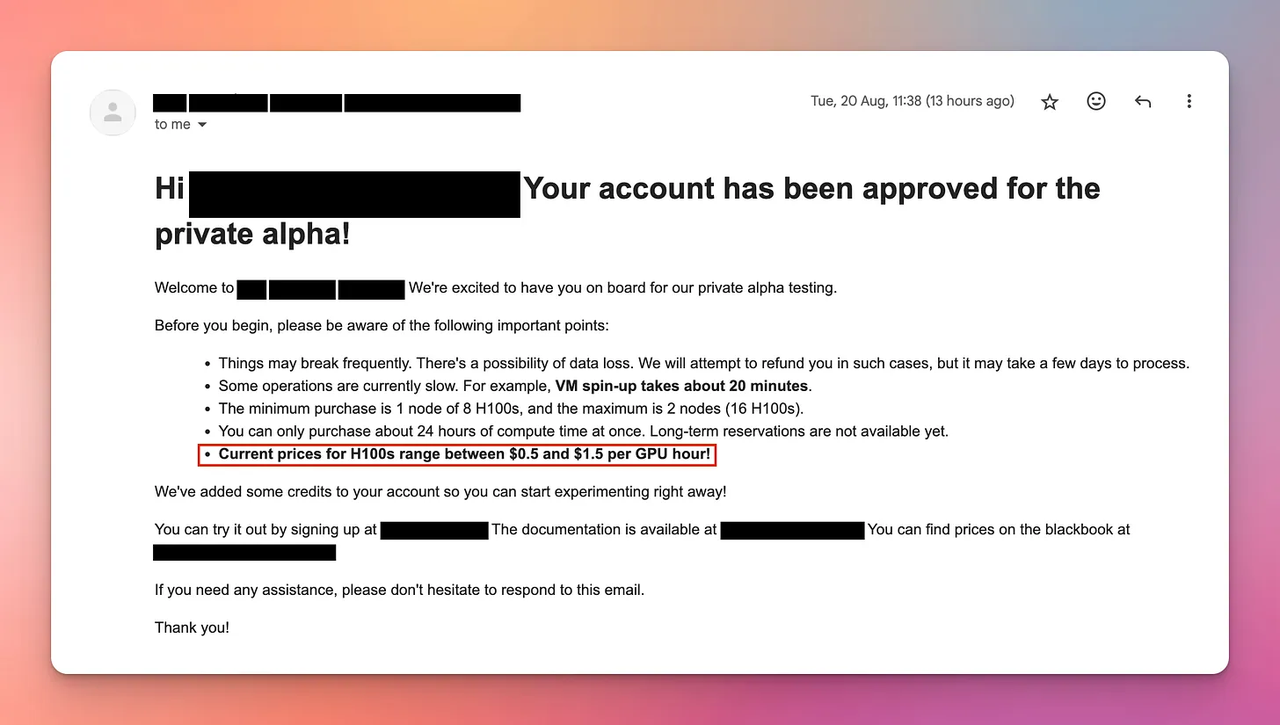

隨著人工智慧和大數據處理需求的成長,企業對高效能GPU(尤其是NVIDIA 的H100)的需求激增,為了支援這些運算密集型任務,全球企業在硬體和基礎設施上初期已投入約6,000 億美元,用於購買GPU、建置資料中心等,以提升運算能力。然而,由於供應鏈的延遲,H100 的價格在2023 年大部分時間裡居高不下,甚至超過每小時4.70 美元,除非買家願意預付大額定金。到了2024 年初,隨著更多的供應商進入市場,H100 的租賃價格降至約2.85 美元,但我開始收到各類推銷郵件,反映了市場供應增加後競爭加劇的情況。

雖然最初H100 GPU 的租賃價格在每小時8 至16 美元之間,但到了2024 年8 月,拍賣式租賃價格已降至每小時1 到2 美元。市場價格每年預計會下降40% 或更多,遠超NVIDIA 預測的4 年內將維持每小時4 美元的預期。這種迅速的價格下滑給那些剛購買高價新GPU 的人帶來了財務風險,因為他們可能無法透過租賃回收成本。

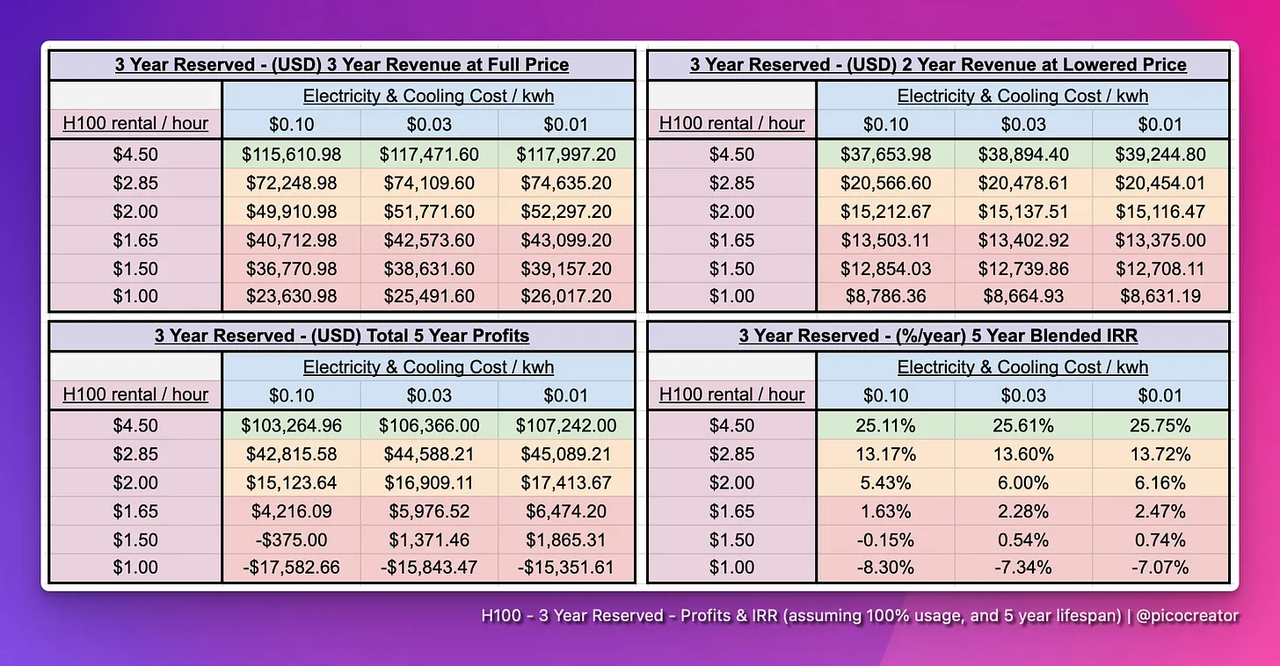

投資5 萬美元買一張H100 的資本報酬率是多少?

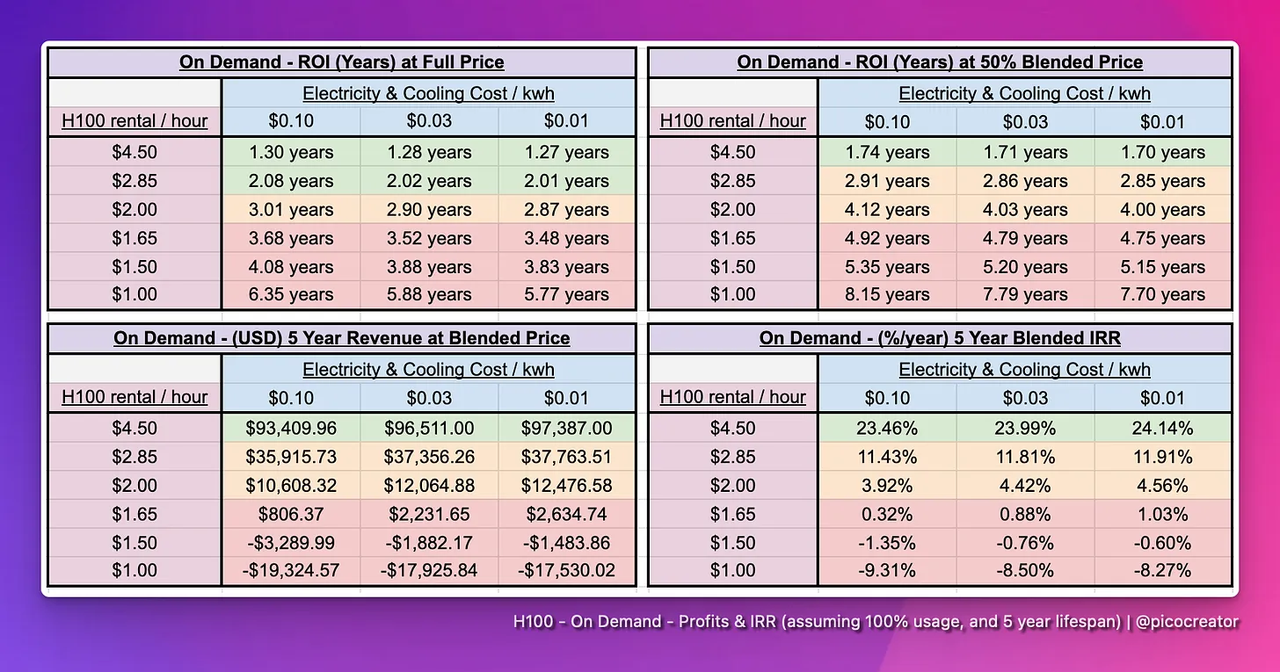

在不考慮電力和冷卻成本的前提下,H100 的購買成本約為5 萬美元,預計使用壽命為5 年。租賃通常有兩種模式:短期按需租賃和長期預訂。短期租賃價格較高,但彈性強,長期預訂則價格較低但穩定。接下來,文章會透過分析這兩種模式的收益,來計算投資者在5 年內能否收回成本並獲得獲利。

短期按需租賃

租賃價格以及對應的收益:

>$2.85 : 超越股市IRR,獲利。

<$2.85 : 收益低於投資股市收益。

<$1.65 : 預計投資損失。

透過「混合價格」模型預測,未來5 年內租金可能下降到目前價格的50%。如果租賃價格保持在每小時4.50 美元,投資回報率(IRR)超過20%,則有利可圖;但當價格降至2.85 美元/ 小時時,IRR 僅有10%,回報顯著降低。如果價格跌破2.85 美元,投資回報甚至可能低於股市收益,而當價格低於1.65 美元時,投資者將面臨嚴重的虧損風險,特別是對於近期購買H100 伺服器的人。

註:「混合價格」是一個假設,認為H100 的租賃價格在未來5 年內逐漸下降到目前價格的一半。這種估計被認為是樂觀的,因為當前市場價格每年下降超過40%,所以考慮價格下降是合理的。

長期預訂租約(3 年以上)

在AI 熱潮期間,許多老牌基礎設施供應商基於過去的經驗,尤其是在加密貨幣早期以太坊PoW 時代經歷過GPU 租金價格暴漲暴跌的周期,因此在2023 年,他們推出了3-5 年的高價預付款租賃合同,以鎖定利潤。這些合約通常要求客戶支付高於每小時4 美元的價格,甚至預付50% 到100% 的租金。隨著AI 需求激增,尤其是在圖像生成領域的基礎模型公司為了搶佔市場先機、率先使用最新的GPU 集群,儘管這些合約價格高昂,但他們不得不簽訂,以快速完成目標模型,提升競爭力。然而,當模型訓練完成後,這些公司不再需要這些GPU 資源,但由於合約鎖定的關係,他們無法輕易退出,為了減少損失,他們選擇將這些租賃的GPU 資源轉售,以回收部分成本。這導致市場上出現了大量轉售的GPU 資源,供應增加,影響了市場的租賃價格和供需關係。

目前的H100 價值鏈

註:價值鏈(Value chain),又稱價值鏈分析、價值鏈模型等。由麥可・波特在1985 年,於《競爭優勢》一書中提出的。波特指出企業要發展獨特的競爭優勢,要為其商品及服務創造更高附加價值,商業策略是結構企業的經營模式,成為一系列的加值過程,而此一連串的加值流程,就是「價值鏈」。

H100 價值鏈從硬體到AI 推理模型,其中的參與部可以大致分為以下幾類

- 與Nvidia 合作的硬體供應商

- 資料中心基礎設施提供者和合作夥伴

- 創投基金、大型公司和新創公司:計劃建立基礎模型(或已完成模型建立)

- 容量經銷商:Runpod、SFCompute、Together.ai、Vast.ai、GPUlist.ai 等。

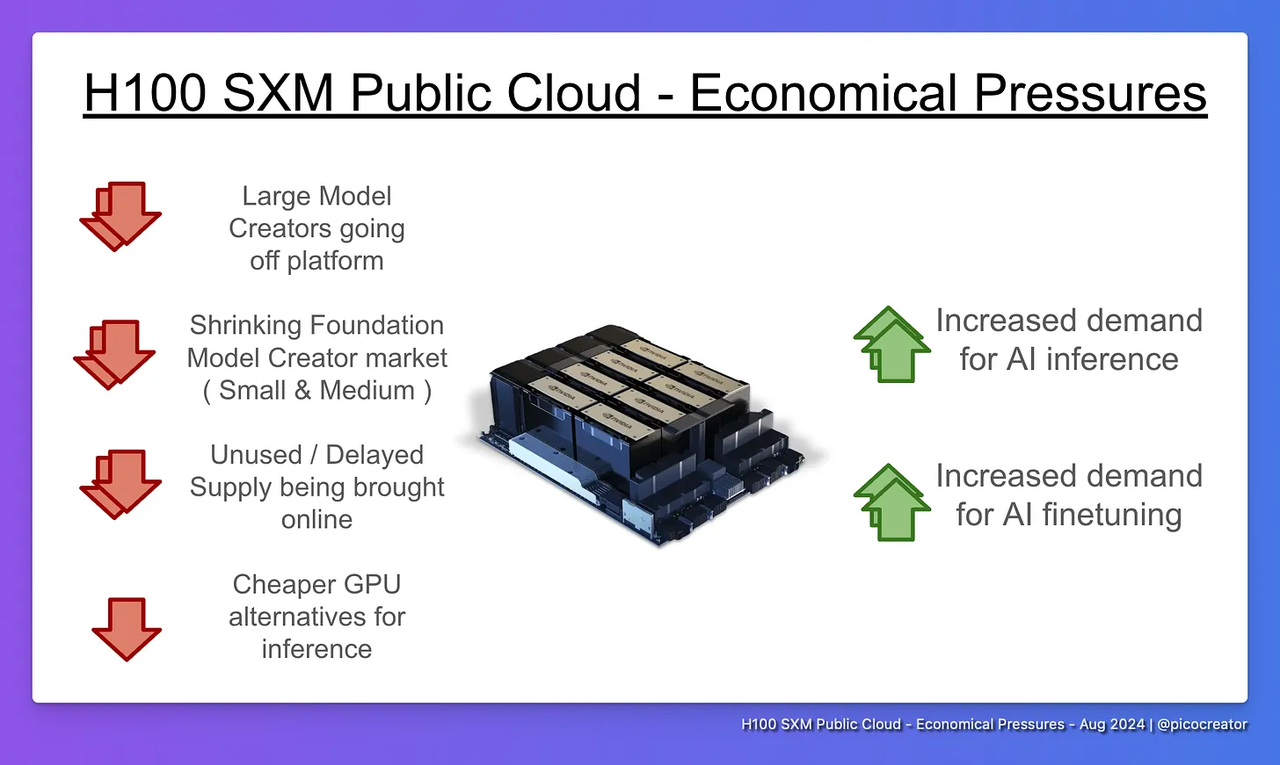

目前的H100 價值鏈包括從硬體供應商到資料中心供應商、AI 模型開發公司、容量經銷商和AI 推理服務提供者等多個環節。市場的主要壓力來自於未使用的H100 容量經銷商不斷轉售或出租閒置資源,以及「足夠好」的開源模型(如Llama 3)的廣泛使用,導致對H100 的需求下降。這兩大因素共同導致了H100 供應過剩,進而對市場價格造成下行壓力。

市場趨勢:開源權重模型的興起

開源權重模型指的是那些儘管沒有正式的開源許可證,但其權重已被公開和免費分發,並且被廣泛應用於商業領域。

這些模型的使用需求主要受到兩大因素推動:一是類似GPT-4 規模的大型開源模型(如LLaMA3 和DeepSeek-v2)的出現,二是小型(80 億參數)和中型(700 億參數)微調模型的成熟和廣泛採用。

由於這些開源模型的成熟度越來越高,企業能夠輕鬆取得並使用它們來滿足大多數AI 應用的需求,尤其是在推理和微調方面。儘管這些模型在某些基準測試中可能略微遜色於專有模型,但它們的性能已經足夠好,可以應對大多數商業用例。因此,隨著開源權重模型的普及,市場對推理和微調的需求正在快速成長。

開源權重模型還有三個關鍵優勢:

首先,開源模型具有很高的靈活性,允許使用者根據特定領域或任務對模型進行微調,從而更好地適應不同的應用情境。其次,開源模型提供了可靠性,因為模型權重不會像某些專有模型那樣在未通知的情況下更新,避免一些因更新而導致的開發問題,增加了使用者對模型的信任。最後,它還確保了安全性和隱私,企業可以確保其提示和客戶資料不會透過第三方API 端點洩露,降低了資料隱私風險。正是這些優勢促使開源模型的持續成長和廣泛採用,特別是在推理和微調方面。

中小型模型創作者需求轉向

中小型模型創建者是指那些沒有能力或計劃從頭開始訓練大型基礎模型(如70B 參數模型)的企業或新創公司。隨著開源模型的興起,許多公司意識到,對現有開源模型進行微調,比自己從頭訓練一個新模型更經濟高效。因此,越來越多的公司選擇微調,而非自行訓練模式。這大大減少了對H100 等計算資源的需求。

微調比從頭訓練便宜得多。微調現有模型所需的運算資源遠少於從頭訓練一個基礎模型。大型基礎模型的訓練通常需要16 個或更多H100 節點,而微調通常只需要1 到4 個節點。這種產業的轉變削減了小型和中型公司對大規模集群的需求,直接減少了對H100 運算能力的依賴。

此外,基礎模型創建的投資減少。在2023 年,許多中小型公司嘗試創建新的基礎模型,但如今,除非他們能夠帶來創新(如更好的架構或對數百種語言的支援),否則幾乎不會再有新的基礎模型建立專案。這是因為市場上已經有足夠強大的開源模型,例如Llama 3,讓小型公司很難證明創建新模型的合理性。投資者的興趣和資金也轉向了微調,而非從頭訓練模型,進一步減少了對H100 資源的需求。

最後,預留節點的過剩容量也是一個問題。許多公司在2023 年高峰期長期預定了H100 資源,但由於轉向微調,他們發現這些預留的節點已經不再需要,甚至有些硬體到貨時已經過時。這些未使用的H100 節點現在被轉售或出租,進一步增加了市場的供應,導致H100 資源供過於求。

整體來看,隨著模型微調的普及、中小型基礎模型創建的減少,以及預留節點的過剩,H100 市場需求大幅下降,供過於求的情況加劇。

導致GPU 算力供應增加和需求減少的其他因素

大型模型創建者脫離開源雲平台

大型AI 模型創建者如Facebook、X.AI 和OpenAI 正逐步從公有雲平台轉向自建私有運算叢集的原因。首先,現有的公有雲資源(如1000 個節點的集群)已無法滿足他們訓練更大模型的需求。其次,從財務角度來看,自建集群更有利,因為購買資料中心、伺服器等資產可以增加公司估值,而租賃公有雲只是費用支出,無法提升資產。此外,這些公司擁有足夠的資源和專業團隊,甚至可以收購小型資料中心公司來幫助他們建立和管理這些系統。因此,他們不再依賴公有雲。隨著這些公司脫離公有雲平台,市場對運算資源的需求減少,可能導致未使用的資源重新進入市場,增加供應。

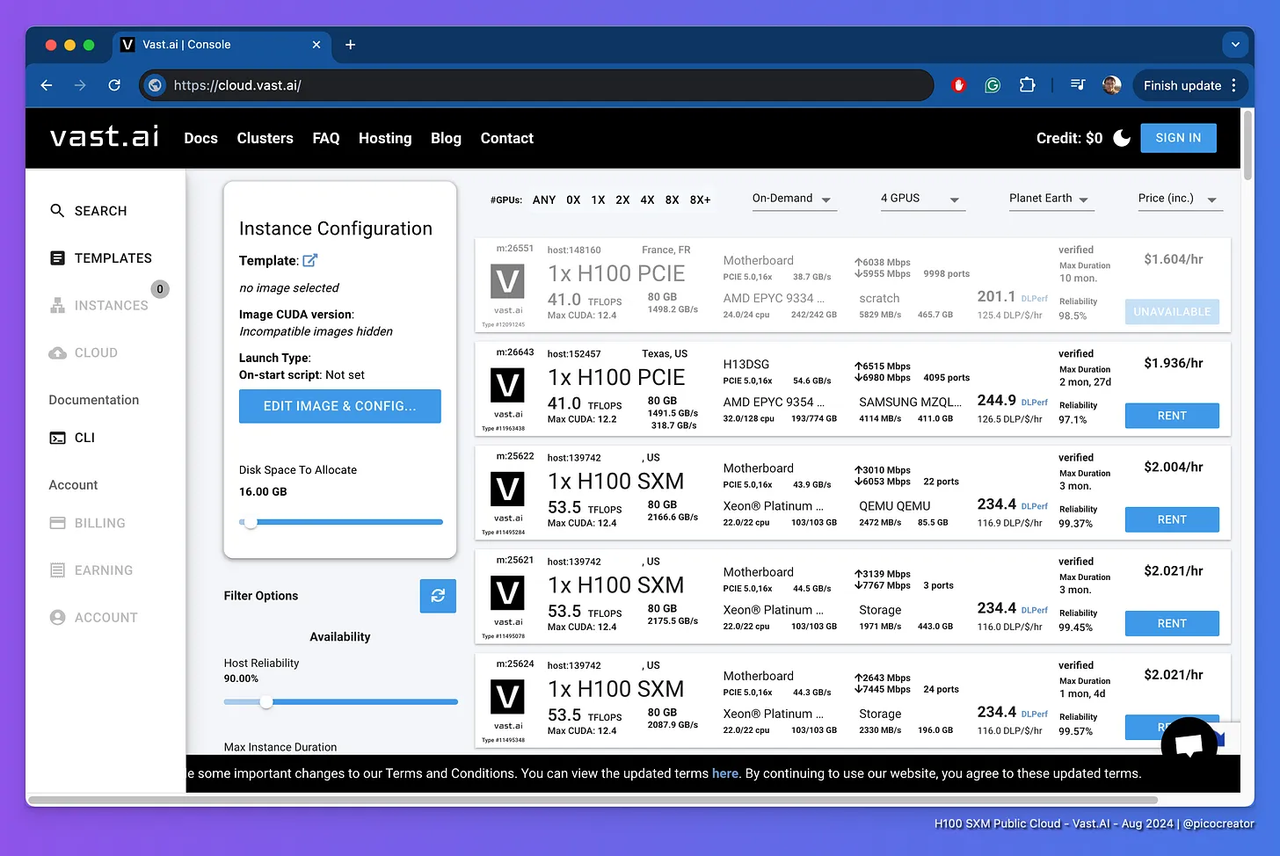

Vast.ai 本質上是一個自由市場體系,來自世界各地的供應商相互競爭

閒置與延遲出貨的H100 同時上線

由於閒置與延遲出貨的H100 GPU 同時上線,促使市場供應量增加,導致價格下降。 Vast.ai 等平台採用自由市場模式,全球供應商在這裡相互競爭價格。 2023 年,由於H100 出貨延遲,許多資源未能及時上線,現在這些延遲的H100 資源開始進入市場,連同新的H200 和B200 設備,以及新創公司和企業閒置的計算資源一起供應。小型和中型群聚的所有者通常擁有8 到64 個節點,但由於利用率低且資金已經耗盡,他們的目標是透過低價出租資源來盡快收回成本。為此,他們選擇透過固定利率、拍賣系統或自由市場定價的方式來競爭客戶,尤其是拍賣和自由市場模式,使得供應商為確保資源被租用而競相降價,最終導致整個市場的價格大幅下降。

更便宜的GPU 替代品

另一個主要因素是,一旦算力成本超出了預算,那麼AI 推理基礎設施便有很多替代方案,特別是如果你運行的是較小的模型。就不需要為使用H100 的Infiniband 支付額外費用。

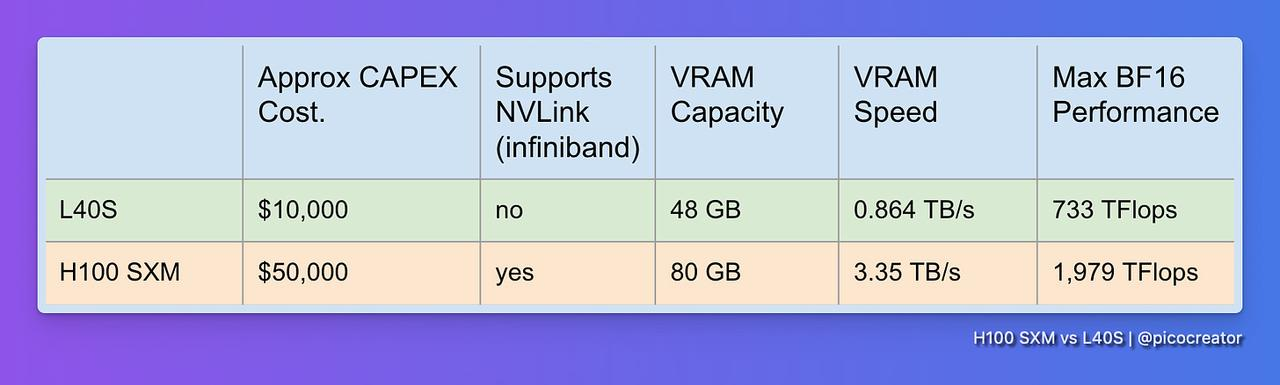

Nvidia 市場細分

H100 GPU 的AI 推理任務中較便宜替代方案的出現,這會直接影響市場對H100 的需求。首先,雖然H100 在AI 模型的訓練和微調上非常出色,但在推理(即運行模型)領域,許多更便宜的GPU 能夠滿足需求,尤其是針對較小的模型。因為推理任務不需要H100 的高端功能(如Infiniband 網路),使用者可以選擇更經濟的替代方案,節省成本。

Nvidia 自己也在推理市場中提供了替代產品,如L40S,這是一款專門用於推理的GPU,性能大約是H100 的三分之一,但價格只有五分之一。雖然L40S 在多節點訓練方面效果不如H100,但對於單節點推理和小型群集的微調,已經足夠強大,這為用戶提供了一個更具性價比的選擇。

H100 Infiniband 叢集效能配置表(2024 年8 月)

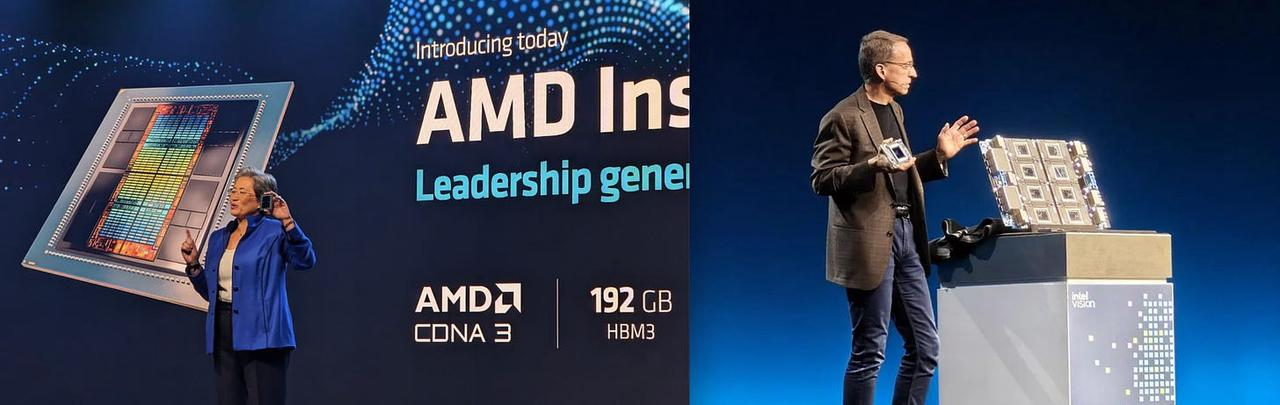

AMD 和Intel 替代供應商

另外,AMD 和Intel 也推出了價格更低的GPU,例如AMD 的MX300 和Intel 的Gaudi 3。這些GPU 在推理和單節點任務中表現優異,價格比H100 便宜,同時擁有更多的記憶體和運算能力。儘管它們在大型多節點集群訓練中還未完全驗證,但在推理任務中已經足夠成熟,成為H100 的有力替代品。

這些較便宜的GPU 已被證明能夠處理大多數推理任務,尤其是常見模型架構(如LLaMA 3)上的推理和微調任務。因此,用戶在解決相容性問題後,可以選擇這些替代GPU,以降低成本。總結來說,推理領域中的這些替代品正逐漸取代H100,特別是在小規模推理和微調任務中,這進一步降低了對H100 的需求。

Web3 領域GPU 使用率下降

由於加密貨幣市場變化,GPU 在加密挖礦中的使用率下降,大量GPU 因此流入雲端市場。儘管這些GPU 由於硬體限制無法勝任複雜的AI 訓練任務,但它們在較簡單的AI 推理工作中表現良好,特別是對於預算有限的用戶,處理較小模型(如10B 參數以下)的任務時,這些GPU 成為性價比很高的選擇。經過最佳化,這些GPU 甚至可以運行大型模型,成本比使用H100 節點更低。

AI 算力租借泡棉後,現在的市場如何?

現在入場面臨的問題:新公有雲H100 集群進入市場較晚,可能無法獲利,一些投資者可能會損失慘重。

新進入市場的H100 公有雲集群面臨的獲利挑戰。如果租賃價格設定過低(低於2.25 美元),可能無法涵蓋營運成本,導致虧損;如果定價過高(3 美元或以上),則可能失去客戶,導致產能閒置。此外,較晚進入市場的集群因為錯過了早期的高價(4 美元/ 小時),難以回收成本,投資者面臨無法獲利的風險。這使得集群投資變得非常困難,甚至可能導致投資者遭受重大損失。

早期入場者的收益情況:早期簽署了長期租賃合約的中型或大型模型創建者,已經收回成本並實現盈利

中型和大型模型創建者透過長期租賃H100 計算資源已經獲得了價值,這些資源的成本在融資時已被涵蓋。雖然部分計算資源未完全利用,但這些公司透過融資市場將這些集群用於當前和未來的模型培訓,並從中提取了價值。即使有未使用的資源,他們也能透過轉售或租賃獲得額外收入,這降低了市場價格,減少了負面影響,整體上對生態系統產生了正面影響。

泡沫破滅後,:價格低廉的H100 可以加速開源式AI 的採用浪潮

低價H100 GPU 的出現將推動開源式AI 的發展。隨著H100 價格下降,AI 開發者和業餘愛好者可以更便宜地運行和微調開源權重模型,使這些模型的採用更廣泛。如果未來閉源模型(如GPT5++)沒有實現重大技術突破,開源模型與閉源模型的差距將縮小,推動AI 應用的發展。隨著AI 推理和微調成本降低,可能引發新的AI 應用浪潮,加速市場的整體進步。

結論:不要購買全新的H100

如果現在投資購買全新的H100 GPU 大概會虧損。不過只有在特殊情況下,例如專案能夠購買到打折的H100、廉價的電力成本,或在其AI 產品在市場上擁有足夠競爭力時,再去投資才可能合理。如果你正在考慮投資,建議將資金投入其他領域或股票市場,以獲得更好的報酬率。