編輯:Alex Liu,Foresight News

Livepeer 於2017 年推出,是第一個完全去中心化的直播視訊串流網路協定。該平台旨在提供一種基於區塊鏈、經濟高效的解決方案來替代傳統集中式廣播。它透過讓製作人在平台上提交作品,然後負責重新格式化和分發內容給用戶和串流媒體平台,旨在改革快速增長的直播視訊串流和廣播行業,引入去中心化生態系統。

簡單點講,透過DePin 設施,使用Livepeer 只需要花費傳統解決方案很小一部分的成本,就能夠用去中心化的方式將視訊內容無縫整合到應用中。

DePin 賽道在今年初熱度激增,LPT 也搭上了成長的快車,代幣價格相較年初翻倍。小編作為一年前10 塊買入9.8 全部賣出的韭菜,決定痛定思痛,仔細研究Livepeer 的新動作—— 推出AI 子網。

創新求變, Livepeer 推出AI 子網

在生成式AI 時代,影片創作迎來了新的變革。

自從Open AI 的Sora 演示展示了透過輸入文字提示即可創建影片的可能性以來,生成影片領域迅速發展。開源AI 視訊模型Stable Diffusion 在短短兩個月內用戶量突破了1000 萬。然而,生成AI 視訊工具的前景面臨嚴峻挑戰。價值490 億美元的GPU 市場由少數全球網路壟斷企業,如NVIDIA、Microsoft Azure 和Amazon Web Services(AWS)控制,導致價格上漲,並造成全球AI 運算瓶頸。

因此,Livepeer 推出了Livepeer AI 子網路:第一個具有AI 運算能力的去中心化視訊處理網路。 Livepeer AI 子網透過利用Livepeer 的數千個GPU 開放網絡,提供低成本、高效能的處理服務,解決集中式AI 運算的結構性問題。基於Livepeer 的去中心化視訊處理網路架構,子網路提供全球可訪問的、經濟實惠的開放視訊基礎設施,並透過區塊鏈代幣經濟激勵無限擴展。

Livepeer AI 子網路具體是什麼?

AI 子網路是Livepeer 視訊基礎設施網路的分支,提供安全開發和測試新去中心化AI 媒體處理市場和工具的沙盒環境。在Livepeer 網路將繼續專注於視訊轉碼和運算的同時, Livepeer AI 子網路將滿足日益增長的AI 運算需求,處理諸如昇級、字幕生成和識別等任務,並支援開發者運行特定視訊和媒體任務的模型。

此子網允許視訊開發者在其應用中添加一系列生成式AI 功能,如文字到圖像、圖像到圖像和圖像到視訊轉換。

這個AI 生成輸出來自Tsunameme.ai - 第一個建構在Livepeer AI 子網路上的示範程式。它使用了文字到圖像和圖像到視訊管道。可嘗試使用Livepeer 測試版產生自己的AI 媒體,網址為https://tsunameme.ai

建立Livepeer AI 子網路的原因

AI 影片工具降低了創作門檻,任何人只需透過幾個文字指令即可創建原本需要場地、專業團隊和數小時編輯的畫面。隨著這些工具的普及,全球集中式AI 運算瓶頸將進一步加劇。此外,去中心化AI 基礎設施還能解決高度集中的伺服器網路固有的單點故障風險以及AI 生成內容所引發的信任和真實性危機。

Livepeer AI 子網路透過提供全球可存取的超低成本基礎設施、開放和無許可的AI 媒體市場以及內容驗證和真實性解決方案,為創建可持續和盈利的開放AI 視訊基礎設施提供了選擇。

Livepeer AI 子網路的工作原理

Livepeer 採用去中心化的按任務付費模式,讓開發者可以按需提交和支付任務費用,而無需預訂昂貴的運算容量。開發者可以根據所需效能和網路供應情況自行設定願意支付的價格。

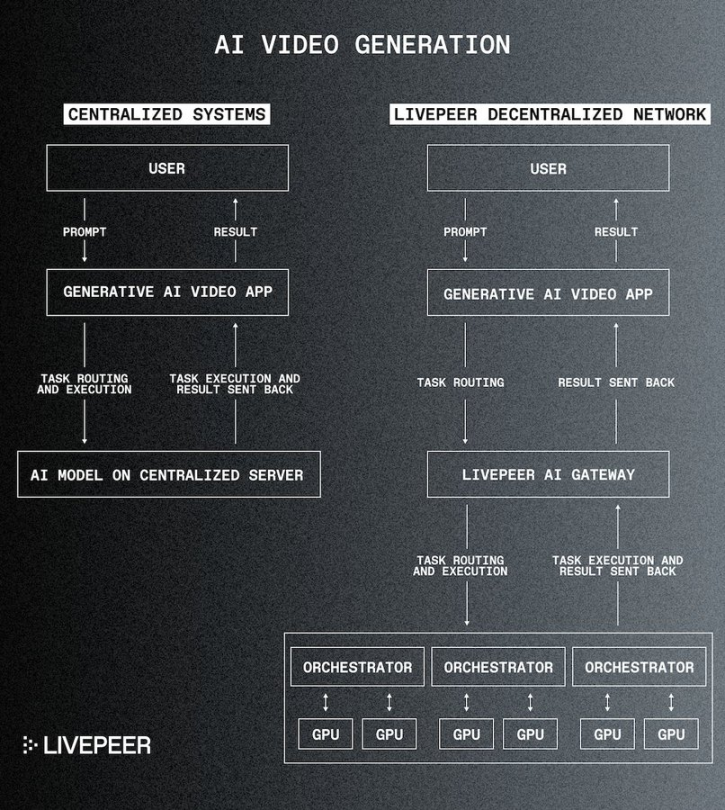

Livepeer AI 網路架構的兩個關鍵元件是:

- AI 協調節點:這些節點執行AI 任務,保持AI 模型在其GPU 上「預熱」以便即時處理,並能動態載入模型,優化回應時間和資源利用。

- AI 網關節點:這些節點管理任務流,依據能力和當前負載將任務分配給適當的協調節點,確保高效的任務分配和系統可擴展性。

該圖說明了Livepeer 如何根據效率將任務分配給分散式GPU 網絡,而不是透過集中式伺服器引導AI 處理請求。

無限可擴展性

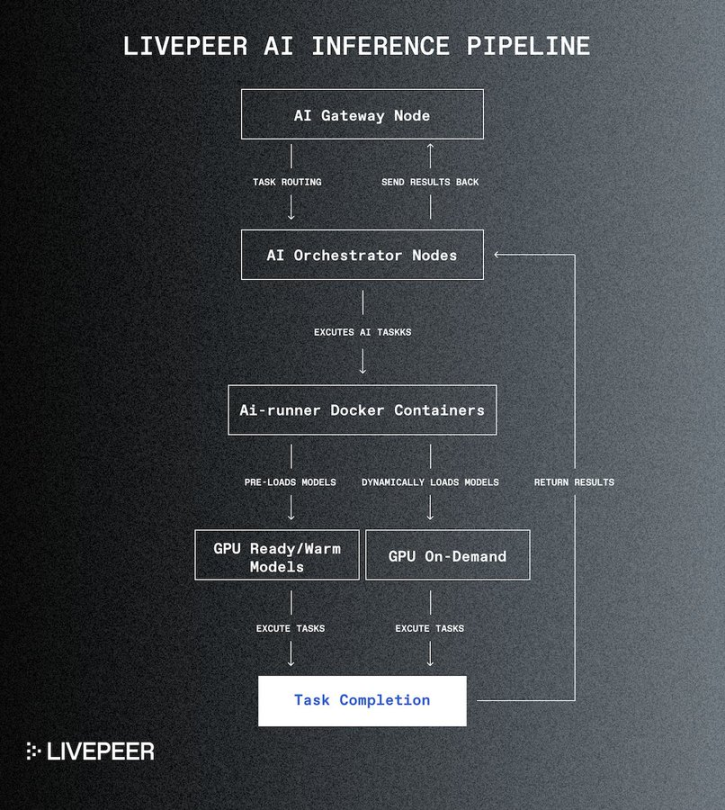

Livepeer AI 網路基礎架構設計為可無限擴展,可根據需求輕鬆整合額外的協調和網關節點。透過專用的AI-runner Docker 映像執行AI 模型,簡化部署並增強新管道的可擴展性。未來的開發將進一步提升效能並擴展容器的能力,以支援越來越複雜的AI 模型和自訂使用者定義的管道。

在AI 子網路上處理任務的技術工作流程。網關節點將任務傳遞給協調器,協調器可能運行相同或不同管道的多個AI-Runner Docker 容器。這些管道可能已經擁有所要求的模型,或者可以根據需要動態載入它們。

參與Livepeer AI 子網

硬體提供者:透過貢獻GPU 賺取費用

現有的Livepeer 協調員可以設定並運行AI 協調節點,執行文字到圖像、圖像到圖像和圖像到影片的推斷任務,增加其現有轉碼收入。

開發者:將模型引入網路作為AI-Worker

開發者可以定義和部署自訂管道和工作流程,以確保其應用程式處於AI 和視訊技術的前沿。開發者還可以設定AI 網關節點,測試和完善其應用,存取AI 任務的API。

Livepeer AI 子網路的推出標誌著該專案的重要里程碑,也是Livepeer 提供全球開放視訊基礎架構使命的下一步。隨著生成式AI 將在未來幾年大幅增加影片內容的創作量,Livepeer 網路旨在確保其具備支援這一成長浪潮的能力。