作者: 秦景春

审阅:0xmiddle

来源:内容公会 - 投研

Web3 最重要的特征之一就是用户自己控制数据,这与 Web2 有着显著的区别,Web2 是互联网巨头来控制用户数据。现在由 BTC 开创的区块链技术使我们摆脱了传统银行或互联网银行等中介的控制,让用户自己可以控制并且点对点交易自己的电子现金;ETH 及其他智能合约公链使用户自己控制并且可以点对点交易各种合约及衍生品资产。然而除了金融资产之外,互联网上还有其他类数据资产,而这些资产现在还没有更为成熟的解决方案,能够使用户自己控制并且实现点对点交易。所以现在 Web3 的用户并不能完全控制自己的数据。之所以这样是因为我们缺乏数据确权的基础设施,要想用户能够掌握自己的数据,那就必须要实现数据确权!要想使得数据能够确权就必须使数据能够达成共识,由于数据状态分为动态和静态,因此要想数据达成共识就必须在传输端和存储端都达成共识这样才能建立数据资产共识,进而使得数据得以确权。数据只有达成共识才能确权,只有达成确权才能产生数据交换或交易,数据只有产生交换或交易才能体现价值,进而才能产生价值互联网。Web2 为什么会产生如此严重的数据孤岛现象,其中很重要的一条原因就是因为数据没有确权。而 Arweave 永久存储 + AO 超并行计算机的出现有望能够改变这一现状进而帮助我们在数据存储和传输两端达成共识。如图所示:

Arveave 永久存储经过几年的发展已经实现了数据存储的共识,(备注:关于这方面的详细资料在网上已经很多了,在这里就不详细解说了),在这面我们重点说一下 ao 超并行计算机是怎样在传输端达成共识的(备注:很多研究 ao 的文章中都提高了 ao 将进程的全息态存储到 arweave 中,但具体是怎样实现的,我看了一下几乎没有文章把具体细节说清楚了,只是大概一句话就过去了,所以在这想把大致的实现路径说清楚):要想在传输端达成共识就必须的保证数据的完整性、一致性、可验证性和传输效率性,在展开介绍之前介绍一下 ao 经济模型的设计原则,这样能够让我们从顶层设计的角度去了解 ao 是如何保证数据安全的。在 ao 白皮书里有这样一段话,大意是:

比特币、以太坊和 Solana 等区块链网络的典型经济模式围绕着购买稀缺区块空间的概念,安全性作为副产品得到补贴。用户支付交易费用,以激励矿工或验证者将他们的交易纳入区块链。然而,这种模式本质上依赖于块空间的稀缺来推动费用收入,这反过来又为网络安全提供了资金。在比特币的安全架构的背景下,它从根本上以区块奖励和交易费用为基础,考虑一个假设的场景,其中区块奖励被消除,交易吞吐量被假设为无限可扩展。在这种情况下,区块空间的稀缺性将被有效地抵消,从而产生最低的交易费用。因此,网络参与者维护安全的经济动机将大大降低,从而增加交易面对潜在安全威胁的脆弱性。Solana 在实践中举例说明了这一理论模型,表明随着网络可扩展性的增加,费用收入相应减少。在没有大量交易费用的情况下,安全资金的主要来源是区块奖励。这些奖励本质上是对代币持有者的征税,表现为那些选择亲自质押代币的人的运营开销,或者表现为那些放弃质押的人在网络中的比例所有权的逐渐稀释。早些时候,我们提出了需要 $AO 代币作为经济价值的统一表示,以支持网络内的安全机制。

通过上述这段话让我看到 ao 的经济模型和其他主流区块链的经济模型有着显著的区别。ao 经济模型是以保护网络安全为主的,因为非金融类数据资产的特性要求必须要保证底层基础设施安全,同时也要保证效率。非金融资产的数据类型多种多样,每类数据的交易场景对系统的安全性、扩展性和时效性等需求都不一样,这就要求 ao 网络安全模型必须要灵活,不能向传统区块链那样一刀切采取统一的共识机制来保证安全性,如果 ao 还采取这样的安全模型的话一方面会造成计算资源的大幅浪费,另外一方面就是严重影响 ao 系统的扩展性。所以 ao 可以做到根据不同的数据类型、数据价值、由客户自主定制安全机制,这其中经济模型起到了重要的调节作用,简而言之就是高价值数据在传输的过程中可以定制高级别的安全机制,低价值的数据可以定制安全成本较低的安全模型,这样一方面能够节省计算资源,另外一方面能够适应不同数据类别的安全需求。当我们分析到这里的时候就可以看到为什么以太坊、比特币、solana 等区块链不太适合做 Web3 数据传输的原因了吧。因为他们的安全模型是统一的,而不是灵活定制的,这本身就不符合非金融类数据资产的传输特征。下面我们深入分析 ao 的经济模型与安全模型相互调节的细节。

1、保持数据的一致性、完整性和可验证性:

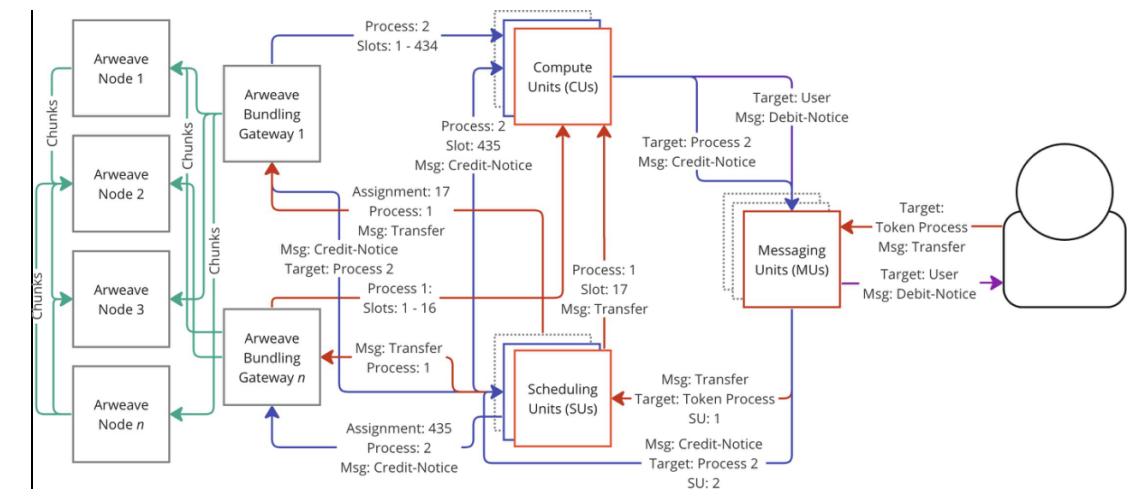

a、技术保障:在 ao 超并行计算机中,消息的传递机制是核心组成部分,它确保了不同计算单元(如 CU、SU 等)之间的有效通信和协作。以下是消息传递的主要过程:

消息生成:用户或进程通过创建消息来发起交互请求。这些消息必须符合 ao 协议规定的格式,以便在网络中正确传输和处理。

信使单元(MU)接收与转发:信使单元(MU)负责接收用户或进程生成的消息,将其中继到网络内的适当 SU 节点。MU 会管理消息的路由,确保它们能够准确无误地到达 SU:在这个过程中 MU 会对消息进行数字签名,以保证数据的完整性。

调度程序单元(SU)处理:当消息到达 SU 节点时,SU 会分配一个唯一的增量 nonce 给消息,以确保其在同一进程中的顺序性,并将消息和分配结果上传到 Arweave 数据层中进行永久存储。

计算单元(CU)处理:计算单元(CU)接收到消息后,会根据消息内容执行相应的计算任务。计算完成后,CU 会生成一个带有特定消息结果的签名证明,并将其返回给 SU。这个签名证明确保了计算结果的正确性和可验证性。具体工作流程如图所示:

💡(备注:此图片出自 ao 白皮书)

另外 ao 超并行计算机的核心原理是将计算和共识解耦,ao 本身不解决消息验证的问题,而是通过将所有 prosess 全息状态都存储到 Arweave 上进而保证所有消息和状态都是可验证的,任何人都可以通过 Arweave 验证消息的一致性,也就是任何人都可以质疑 ao 消息的正确性,任何人都可以通过 Arweave 发起挑战进而验证消息,这样一方面使 ao 摆脱了传统区块链的束缚:传统区块链所有节点的计算和验证都是并行的,这样虽然增强了系统安全性但也会极大的消耗计算资源,同时也无法呈现高扩展性,例如在以太坊系统里面无论添加多少个节点都不会显著提高系统处理的速度。然而正是因为 ao 的这一特性,能够具备高度扩展的特征;另外一方面也能保证所有的数据都是可验证的,这就是 ao 设计的巧妙性,将验证成本转移到链下同时保证可验证性。

b、经济模型保障:上述过程是 ao 超并行计算机消息传递的大致流程。除此 MU\SU\CU 等三类节点都需要质押 $AO,并且针对这三种节点可能出现的各种意外情况都提供了相应的解决方案,例如:如果发现 MU 没有做数字签名或者签署了无效信息,则系统会对 mu 的质押资产进行削减。如果 MU 发现 CU 提供了无效证明,那系统也会对 CU 质押资产进行消减。针对 MU\SU\CU 等节点出现的各种问题在 ao 白皮书中都设定了针对的基于经济模型的解决方案,进而保证这三种节点都不会作恶。除此之外 ao 超并行计算机还通过权益集合机制许可 MU 可以集合多个 CU 的证明进而确保信息传递的完整性和可信度(具体过程可详见 ao 白皮书 5.6 ao sec 起源过程和 5.5.3 权益集合。)

另外 SIV 子质押共识机制,允许用户需要对结果达成共识或部分共识:客户端可以自主设定参与者或验证者的数量,从而控制共识对成本和延迟的影响。

综上所述,ao 超并行计算机通过技术模型和经济模型两种方式相结合来保证数据的完整性、一致性及可验证性。并且因为各类数据的安全性不同,ao 提供灵活定制的安全模型。

2、防止数据泄密:

ao 通过引入经济质押模型鼓励 MU/SU/CU 节点提升安全保障措施,并且通过安全等级购买机制、股权排他期和股权时间价值等机制来保障数据的安全性和灵活性,大致情况是这样:客户可以对所购买的消息进行投保,这种保险的价值跟消息的价值、质押者的预期收益率、消息的安全保障时间等因素有关,这样一方面能够保障数据传输安全,促使质押者能够有动力提供更高的安全保证;另外一方面就是如果发生消息泄密的情况也能够保证消息接收者的利益,进而使得消息的买方和卖方都能够达成共识,从而促进数据资产交易。另外 ao 与 PADO 进行了合作,用户可以通过 PADO 的 zkFHE 技术加密自己的数据,并且将其安全的存储在 arweave 上,同时因 arweave 也是去中心化的,这样能够防止单点故障的发生。通过这些机制能够保障数据在传输和存储的过程中得到充分的保护。

3、保障数据传输的效率性:

与以太坊等网络不同,后者的基础层和每个 Rollup 实际上都作为单一进程运行,ao 支持任意数量的进程并行运行,同时确保计算的可验证性保持完整。此外,这些网络在全球同步状态下运行,而 ao 进程保持自己的独立状态。这种独立性使得 ao 进程能够处理更高数量的交互和保持计算的可扩展性,使其特别适合对高性能和可靠性有需求的应用程序,此外由于 ao 上的 process 可以全息投影到 Arweave 上,通过 Arweave 上的消息日志可反向触发执行 ao 进程,一但发现单个 process 出现中断则可以通过 Arweave 马上重新起用 Process, 这样一面可以防止单点故障发生,另外一方面也可以在最短的时间内恢复Process状态,进而保障消息传递的效率。

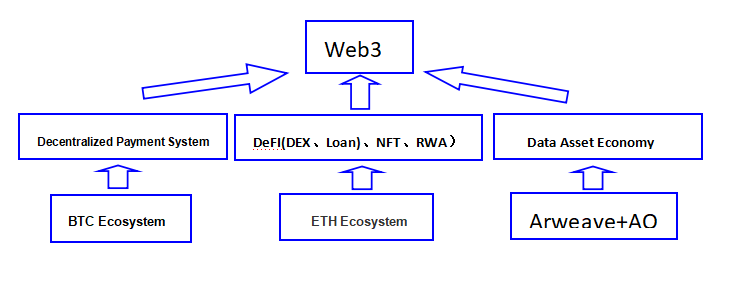

本文深入浅出的阐述了 ao 如何从传输端保证消息传输的完整性、一致性、可验证性、效率性及防泄密等方面。当这几个方面都能够得到保障的时候就可以在传输端达成数据共识。而在存储端 Arweave 已经运营了几年了,实现了数据的永久存储保证了数据在存储端的共识。所以 Arweave 永久存储 + ao 超并行计算机这种方案有望解决大量数据在存储和传输两端的共识问题。如果能够解决这一问题,这将带来革命性的变化:海量的非金融类数据资产能够产生共识进而大大加速数据资产确权,进而能够帮助解决 web3 数据资产确权的问题。数据资产只有确权了之后才能产生大量的经济活动,这样才能实现真正的价值互联网。现在 BTC 解决了电子现金确权及交易的问题,使得我们每个人能够掌控电子现金,以太坊通过智能合约和区块链解决了各种金融资产的确权及交易问题;而 Arweave 永久存储 + ao 超并行计算机有望帮助解决数据资产的确权及交易问题,当然本文重点是从数据资产共识这个角度去阐述的,因为这是数据资产确权和交易的关键。个人认为 Arveave 永久存储 + ao 超并行计算机有望与 BTC、以太坊并驾齐驱,形成良好的互补,共同解决 Web3 的关键性问题,进而帮助我们迈进价值互联网。如图所示:

项目风险:

- ao 与 arweave 的衔接性:ao 的超并行计算可能给 arweave 带来巨大的吞吐量与挑战,进而致使消息不能实现全息投影或者导致其他方面的系统不稳定。

- MU/SU/CU 是 ao 系统的关键节点,有可能出现中心化的特征,进而产生腐败并且导致项目的不稳定,希望 ao 官网能够建立去中性化的声誉评估系统允许 DAO 成员自行评估三种节点的优越性,进而对三种节点形成公平公开的评价机制与竞争机制。

- Arweave 主打数据永久存储,随着规模的扩大,可能会面临各国政府的审查,不知道官方有没有相应的策略或者解决方案,这些都有待观察。

- 经济模型的设计有待验证:ao 的安全模型对经济模型的依赖权重比较高,虽然 ao 也通过上述技术手段保证了一些数据的安全性,但如果经济模型不能很好的发挥作用的话,那就会降低各个质押环节的安全性,进而不能保证数据安全。ao 的安全模型与传统的区块链安全模型是不一样的:区块链的核心原理是让攻击者付出惨重的代价来保证安全性,具体是通过经济模型、共识机制、最长链原则等相结合通过数学原理来实现让攻击者的损失大于收入,因此具有强大的安全保证;而 ao 安全模型的设计跟传统的 web2 的安全模型设计原则是一样的:通过加强防御措施来低于外部攻击,而防御措施的强弱更多是通过 ao 经济模型来调节,以便让各个质押节点有更多的动力和压力来提升安全性,因此如果经济模型设计不合理的话对 ao 项目的实施可以说是致命的。

当然以上只是从技术模型、经济模型等角度分析的,如果要考虑一个项目的潜力还需要考虑项目团队的技术实力、综合背景,及项目的生态状况、所属赛道或方向的潜力等多种因素,关于这些方面后期也会逐步跟大家一起探讨。